A ascensão dos agentes autônomos baseados em Inteligência Artificial (IA) está remodelando a forma como empresas, governos e indivíduos interagem com sistemas tecnológicos.

Em meio a esse avanço, o debate sobre governança e ética em agentes de IA torna-se essencial para garantir o uso responsável, seguro e alinhado com valores humanos.

Este artigo explora os fundamentos e as boas práticas para criar um ecossistema de IA confiável e transparente.

O que são agentes de IA e por que demandam governança específica

Diferente de modelos estáticos ou preditivos, os agentes de IA têm a capacidade de observar o ambiente, tomar decisões autônomas e executar ações com mínima ou nenhuma intervenção humana.

Essa característica cria novos desafios éticos e operacionais, pois envolve alto grau de autonomia, contexto dinâmico e aprendizado contínuo.

Quando um agente comete um erro, como atribuir um diagnóstico errado ou realizar uma transferência bancária indevida, surge a pergunta inevitável: quem assume a responsabilidade?

A resposta exige uma estrutura de governança de IA robusta e multidisciplinar, baseada em accountability, transparência e alinhamento regulatório.

Se você deseja atuar profissionalmente nesse ecossistema de IA com responsabilidade, conheça a Formação Gestor de Agentes e Automações com IA da NoCode StartUp — uma trilha prática e estratégica para quem quer liderar com ética e eficiência.

Princípios fundamentais de ética em agentes inteligentes

O desenvolvimento de agentes inteligentes deve estar ancorado em valores como beneficência, justiça, não maleficência e autonomia.

Esses princípios estão presentes em frameworks internacionais como os OECD AI Principles e também no EU AI Act, legislação pioneira da União Europeia para classificação de risco e responsabilidade.

O princípio da explicabilidade (Explainable AI) é um dos mais relevantes. Ele assegura que decisões tomadas por um agente possam ser compreendidas, auditadas e justificadas por humanos.

Isso é crítico em setores como saúde, finanças e educação, onde a opacidade pode gerar prejuízos irreversíveis.

Estratégias para implementar governança de IA eficaz

Criar uma estrutura de governança não se limita a documentar diretrizes. Envolve práticas operacionais como a criação de um comitê de ética em IA, treinamentos regulares, auditorias técnicas e definição clara de responsabilidades.

Segundo a Electric Mind, é essencial incorporar processos iterativos e colaborativos, alinhando equipes de tecnologia, jurídico, produto e áreas regulatórias.

Ferramentas como o AI Explainability 360 da IBM e os recursos do Azure Responsible AI Dashboard ajudam no monitoramento de desempenho, viés e alinhamento ético.

Para quem quer se aprofundar nas ferramentas líderes do mercado, a Formação em IA NoCode oferece domínio prático das tecnologias e frameworks exigidos pelas novas exigências regulatórias.

Riscos comuns em ambientes com agentes autônomos

Entre os principais riscos associados aos agentes de IA estão o viés algorítmico, a falta de supervisão humana e a Shadow AI — quando colaboradores utilizam ferramentas não autorizadas para automação.

Em ambientes corporativos, esses riscos podem comprometer desde a conformidade com a LGPD até a reputação institucional.

A ausência de mecanismos de contenção e auditoria pode resultar em prejuízos financeiros, vazamentos de dados e decisões discriminatórias.

Por isso, a governança precisa incluir planos de contingência e atualização contínua dos modelos.

Casos de uso reais e boas práticas adotadas

Empresas como a Microsoft e a AWS têm liderado boas práticas de governança de IA, especialmente em setores de alto impacto.

Microsoft: IA responsável em serviços de nuvem

A Microsoft implementou seu framework de governança de IA em serviços Azure, incluindo agentes cognitivos usados por hospitais e instituições financeiras.

A empresa disponibiliza relatórios públicos de impacto, promovendo transparência e accountability em escala global.

Amazon: agentes logísticos auditáveis com AWS

A Amazon utiliza agentes de IA na automação de seus centros de distribuição global. Usando o AWS AI Services, a empresa incorporou trilhas de auditoria e modelos treinados com princípios de equidade algorítmica.

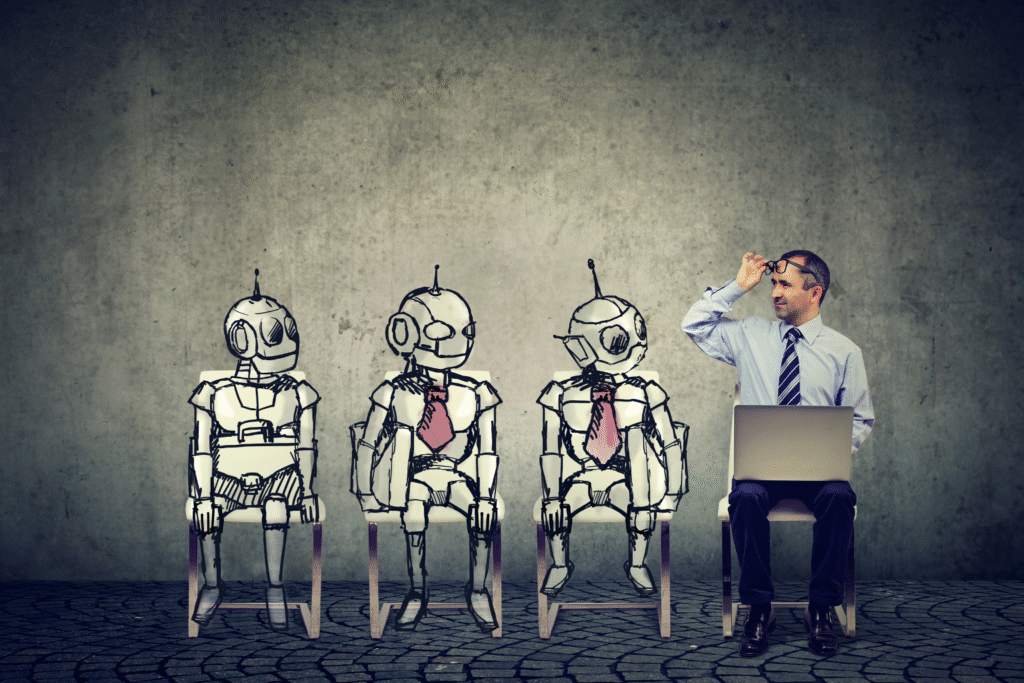

Unilever: IA ética para análise de talentos

A Unilever adotou agentes de IA para análise automatizada de entrevistas em vídeo durante o processo de recrutamento.

O sistema foi desenvolvido com foco em viés zero e passou por auditorias independentes para garantir equidade.

Reino Unido: governança nacional de IA com foco público

O governo britânico, por meio do Centre for Data Ethics and Innovation (CDEI), criou diretrizes éticas para agentes de IA aplicados em serviços públicos, como assistência social e saúde.

A iniciativa enfatiza explicabilidade e o monitoramento contínuo.

Ferramentas e recursos para governança de agentes de IA

Além das já citadas, outras ferramentas relevantes incluem:

Esses recursos permitem desde o rastreamento de mudanças nos modelos até a geração de relatórios para auditoria e conformidade, o que contribui para elevar a confiabilidade do ecossistema de IA.

Tendências futuras e legislação emergente

O futuro da governança e ética em agentes de IA passa pela integração com regulações como o AI Act e a criação de sistemas de alinhamento automático entre valores humanos e objetivos dos agentes.

Pesquisadores da Arion Research destacam a emergência de modelos de accountability distribuída, nos quais múltiplos atores assumem responsabilidades distintas dentro do ciclo de vida do agente.

A aplicação de técnicas de explainability e fairness, aliadas a testes de robustez, será cada vez mais exigida em setores como defesa, saúde e educação.

A tendência é que órgãos reguladores exijam relatórios periódicos de desempenho ético e impacto social.

Caminhos para um ecossistema de IA confiável e humano

A construção de um ecossistema baseado em governança e ética em agentes de IA exige mais do que tecnologias sofisticadas: requer compromisso institucional, educação contínua e regulações inteligentes.

As organizações que saírem na frente com estruturas sólidas, ferramentas de monitoramento e uma cultura de responsabilidade têm mais chances de inovar com segurança.

Se você deseja se preparar profissionalmente para aplicar governança, ética e automações com IA de forma estratégica, acesse a Formação Gestor de Agentes e Automações com IA e aprenda na prática como liderar projetos com responsabilidade e domínio técnico.