O LlamaIndex é um framework de código aberto projetado para conectar modelos de linguagem de grande porte (LLMs) a dados privados e atualizados, que não estão diretamente disponíveis nos dados de treinamento dos modelos.

A definição do LlamaIndex gira em torno de sua função como middleware entre o modelo de linguagem e as fontes de dados estruturadas e não estruturadas. Você pode acessar a documentação oficial para obter uma visão detalhada de suas funcionalidades técnicas.

Conteúdo

LlamaIndex para que ele serve?

Integração com LLMs

O LlamaIndex é uma ferramenta desenvolvida para facilitar a integração entre grandes modelos de linguagem (LLMs) e fontes de dados externas que não estão diretamente acessíveis ao modelo durante a geração de respostas.

Essa integração se dá por meio do paradigma conhecido como RAG (Retrieval-Augmented Generation), que combina técnicas de recuperação de dados com geração de linguagem natural.

Aplicações práticas

A explicação simples do LlamaIndex está na sua utilidade: ele transforma documentos, bancos de dados e fontes diversas em conhecimento estruturado, pronto para ser consultado por uma IA.

Ao fazer isso, resolve uma das maiores limitações dos LLMs – a impossibilidade de acessar informações atualizadas ou privadas sem reconfiguração.

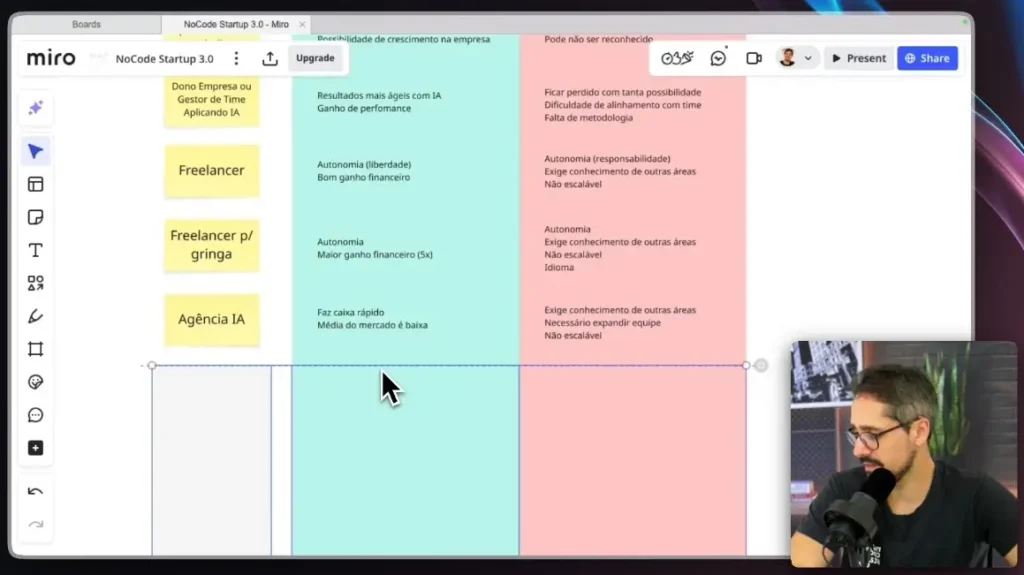

O uso do LlamaIndex com IA amplia os casos de aplicação da tecnologia, desde assistentes jurídicos a bots de atendimento e motores de busca internos.

Limitações resolvidas

O LlamaIndex soluciona uma limitação fundamental dos LLMs: a dificuldade de acessar, em tempo real, dados atualizados ou privados.

Funcionando como uma camada de memória externa, ele conecta modelos de linguagem a fontes como documentos, planilhas, bancos de dados SQL e APIs, sem a necessidade de ajustar os pesos do modelo.

Sua ampla compatibilidade com formatos como PDF, CSV, SQL e JSON o torna aplicável a diversos setores e casos de uso.

Essa integração se baseia no paradigma RAG (Retrieval-Augmented Generation), que combina recuperação de informações com geração de linguagem natural, permitindo que o modelo consulte dados relevantes no momento da inferência.

Como framework, o LlamaIndex estrutura, indexa e disponibiliza esses dados para que modelos como o ChatGPT possam acessá-los de forma dinâmica.

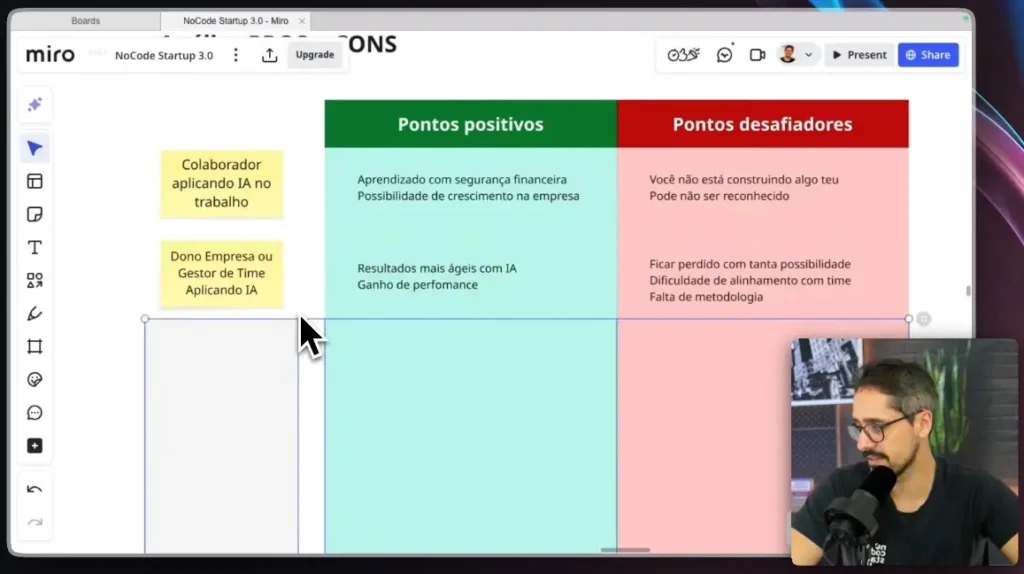

Isso permite que tanto equipes técnicas quanto não técnicas desenvolvam soluções de IA com maior agilidade, menos custos e sem a complexidade de treinar modelos do zero.

Como usar o LlamaIndex com modelos LLM como o ChatGPT?

Confira também a Formação N8N para automatizar fluxos com ferramentas no-code em projetos com IA.

Etapas de uso

Formação Gestor de Agentes e Automações com IA é indicada para quem deseja aprender a aplicar esses conceitos de forma prática, especialmente no desenvolvimento de agentes autônomos baseados em IA generativa.

A integração do LlamaIndex com LLMs, como o ChatGPT, envolve três etapas principais: ingestão de dados, indexação e consulta. O processo começa com a coleta e transformação dos dados em um formato compatível com o modelo.

Em seguida, esses dados são indexados em estruturas vetoriais que facilitam a recuperação semântica, permitindo que o LLM os consulte durante a geração de texto. Por fim, a aplicação envia perguntas ao modelo, que responde com base nos dados recuperados.

Para conectar o LlamaIndex ao ChatGPT, a abordagem típica envolve o uso das bibliotecas em Python disponíveis no repositório oficial. A ingestão pode ser feita por meio de leitores como SimpleDirectoryReader (para PDF) ou CSVReader, e a indexação com VectorStoreIndex.

Exemplo Prático: Criando um Agente de IA com Documentos Locais

Vamos detalhar um exemplo prático de como usar o LlamaIndex para criar um agente de IA que responde a perguntas com base em um conjunto de documentos PDF locais. Este exemplo ilustra as etapas de ingestão, indexação e consulta de forma mais aprofundada.

1 – Preparação do Ambiente: Certifique-se de ter o Python instalado e as bibliotecas necessárias. Você pode instalá-las via pip: bash pip install llama-index pypdf

2 – Ingestão de Dados: Imagine que você tem uma pasta chamada meus_documentos contendo vários arquivos PDF. O SimpleDirectoryReader do LlamaIndex facilita a leitura desses documentos.

Neste passo, o SimpleDirectoryReader lê todos os arquivos suportados (como PDF, TXT, CSV) da pasta especificada e os converte em objetos Document que o LlamaIndex pode processar.

3 – Indexação dos Dados: Após a ingestão, os documentos precisam ser indexados. A indexação envolve a conversão do texto dos documentos em representações numéricas (embeddings) que capturam o significado semântico.

Esses embeddings são então armazenados em um VectorStoreIndex. python # Cria um índice vetorial a partir dos documentos # Por padrão, usa embeddings do OpenAI e um VectorStore simples em memória index = VectorStoreIndex.from_documents(docs) O VectorStoreIndex é a estrutura de dados central que permite ao LlamaIndex realizar buscas eficientes por similaridade semântica.

Quando uma consulta é feita, o LlamaIndex busca os trechos mais relevantes nos documentos indexados, em vez de fazer uma busca por palavras-chave simples.

4 – Consulta e Geração de Respostas: Com o índice criado, você pode agora fazer perguntas. O as_query_engine() cria um motor de consulta que interage com o LLM (como o ChatGPT) e o índice para fornecer respostas informadas pelos seus dados.

- Quando query_engine.query() é chamado, o LlamaIndex faz o seguinte:

- Converte sua pergunta em um embedding.

- Usa esse embedding para encontrar os trechos mais relevantes nos documentos indexados (Recuperação).

- Envia esses trechos relevantes, juntamente com sua pergunta, para o LLM (Geração).

- O LLM então gera uma resposta com base no contexto fornecido pelos seus documentos.

Este fluxo demonstra como o LlamaIndex atua como uma ponte, permitindo que o LLM responda a perguntas sobre seus dados privados, superando as limitações de conhecimento pré-treinado do modelo.

Casos de Uso Detalhados

O LlamaIndex, ao conectar LLMs a dados privados e em tempo real, abre um leque vasto de aplicações práticas. Vamos explorar dois cenários detalhados para ilustrar seu potencial:

- Assistente Jurídico Inteligente:

- Cenário: Um escritório de advocacia possui milhares de documentos legais, como contratos, jurisprudências, pareceres e leis. Advogados gastam horas pesquisando informações específicas nesses documentos para preparar casos ou dar consultoria.

- Solução com LlamaIndex: O LlamaIndex pode ser usado para indexar toda a base de documentos do escritório. Um LLM, como o ChatGPT, integrado ao LlamaIndex, pode atuar como um assistente jurídico.

Os advogados podem fazer perguntas em linguagem natural como “Quais são os precedentes legais para casos de disputa de terras em áreas de proteção ambiental?” ou “Resuma as cláusulas de rescisão do contrato X”.

O LlamaIndex recuperaria os trechos mais relevantes dos documentos indexados, e o LLM geraria uma resposta concisa e precisa, citando as fontes. - Benefícios: Redução drástica do tempo de pesquisa, aumento da precisão das informações, padronização das respostas e liberação dos advogados para tarefas de maior valor estratégico.

- Chatbot de Suporte ao Cliente para E-commerce:

- Cenário: Uma loja online recebe um grande volume de perguntas repetitivas de clientes sobre status de pedidos, políticas de devolução, especificações de produtos e promoções. O suporte humano fica sobrecarregado, e o tempo de resposta é alto.

- Solução com LlamaIndex: O LlamaIndex pode indexar o FAQ da loja, manuais de produtos, políticas de devolução, histórico de pedidos (anonimizado) e até mesmo dados de estoque.

Um chatbot alimentado por um LLM e LlamaIndex pode responder instantaneamente a perguntas como “Qual o status do meu pedido #12345?”, “Posso devolver um produto após 30 dias?” ou “Quais são as especificações do smartphone X?”.

Benefícios: Atendimento 24/7, redução da carga de trabalho da equipe de suporte, melhoria da satisfação do cliente com respostas rápidas e precisas, e escalabilidade do atendimento sem aumento proporcional de custos.

Quais são as vantagens do LlamaIndex em relação a outras ferramentas de RAG?

Uma das principais vantagens do LlamaIndex é a sua curva de aprendizado relativamente acessível. Comparado a soluções como LangChain e Haystack, ele oferece maior simplicidade na implementação de pipelines RAG, ao mesmo tempo em que mantém flexibilidade para personalizações avançadas.

Sua arquitetura modular facilita a substituição de componentes, como sistemas de armazenamento vetorial ou conectores de dados, conforme as necessidades do projeto.

O LlamaIndex também se destaca pelo suporte a múltiplos formatos de dados e pela documentação clara. A comunidade ativa e o ritmo constante de atualizações tornam o framework uma das melhores ferramentas de RAG para desenvolvedores e startups.

Em comparação entre ferramentas de RAG, o LlamaIndex vs Lang Chain evidencia diferenças significativas: enquanto o LangChain é ideal para fluxos complexos e aplicações orquestradas com múltiplas etapas, o LlamaIndex favorece a simplicidade e o foco em dados como fonte principal de contextualização.

Para uma comparação aprofundada, veja este artigo técnico da Towards Data Science, que explora os cenários ideais de uso de cada ferramenta. Outra fonte relevante é o artigo RAG with LlamaIndex do blog oficial da LlamaHub, que discute benchmarks de desempenho.

Também recomendamos o post Benchmarking RAG pipelines, que apresenta testes comparativos com métricas objetivas entre diferentes frameworks.

Comece a usar o LlamaIndex na prática

Agora que você compreende a definição do LlamaIndex e os benefícios de sua integração com modelos LLM como o ChatGPT, é possível dar início ao desenvolvimento de soluções personalizadas de IA com base em dados reais.

O uso do LlamaIndex com IA não apenas aumenta a precisão das respostas, como também libera novas possibilidades de automação, personalização e inteligência de negócios.

A NoCode StartUp oferece diversas trilhas de aprendizado para profissionais interessados em aplicar essas tecnologias no mundo real. Desde a Formação em Agentes com OpenAI até a Formação SaaS IA NoCode, os cursos abordam desde conceitos básicos até arquiteturas avançadas com uso de dados indexados.