Tempo estimado de leitura: 9 minutos

Criado pela rival da OpenAI, Anthropic, Claude é um chatbot “útil, inofensivo e honesto” com uma constituição ética incorporada.

Com sua abordagem única para segurança e ética de IA, Claude está emergindo como um forte concorrente do ChatGPT, oferecendo várias vantagens distintas.

Neste artigo, vamos nos aprofundar no que é Claude AI, como ele se compara ao ChatGPT e o que o destaca no campo em rápida evolução dos chatbots de IA.

O que é Claude AI?

Claude é um chatbot de inteligência artificial desenvolvido pela Anthropic, uma importante startup de IA que recebeu financiamento substancial de gigantes da tecnologia como Google e Amazon.

A missão da Anthropic é criar sistemas de IA que sejam mais úteis, inofensivos e honestos, priorizando responsabilidade, ética e segurança geral.

Claude foi projetado para gerar conteúdo de texto e se envolver em conversas naturais e humanas com os usuários.

Ele pode responder a entradas baseadas em texto ou imagem e é acessível pela web ou por um aplicativo móvel.

A IA é treinada para lidar com uma variedade de tarefas, incluindo resumo, edição, perguntas e respostas, tomada de decisão e muito mais.

A Anthropic oferece um conjunto de três modelos de IA sob a marca Claude, cada um com recursos exclusivos:

- Claude 3 Opus: este modelo se destaca em lidar com tarefas complexas e prompts abertos com notável fluência e compreensão humana.

- Claude 3.5 Sonnet: projetado para velocidade, este modelo é ideal para tarefas que exigem respostas rápidas, como recuperação de conhecimento ou automação de vendas.

- Claude 3 Haiku: o modelo mais rápido e compacto, ele pode processar rapidamente documentos densos em dados e responder a consultas simples com velocidade incomparável.

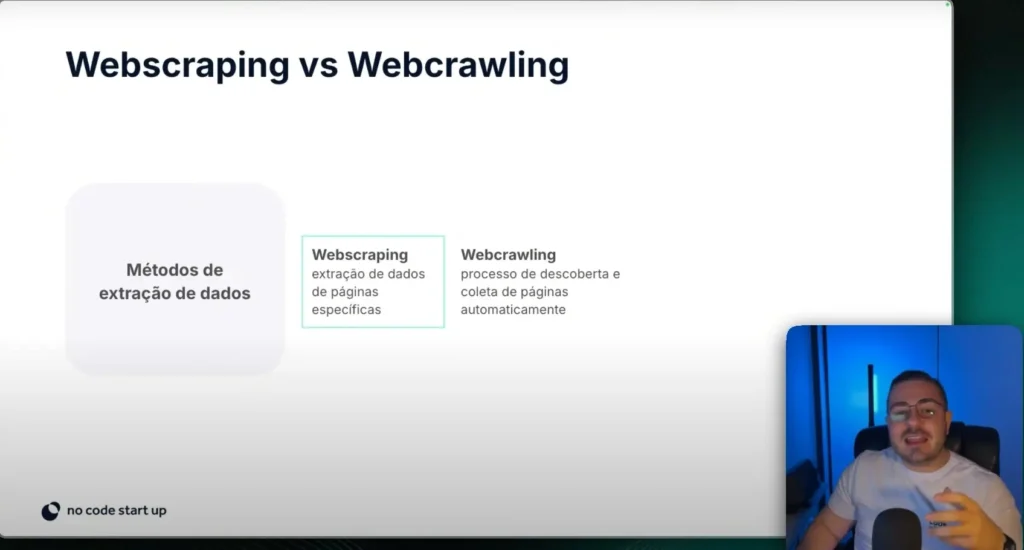

Como funciona?

Claude, como outros modelos de linguagem grande (LLMs), é treinado em grandes quantidades de dados de texto, incluindo artigos da Wikipédia, notícias e livros.

Ele usa métodos de aprendizado não supervisionados para prever a próxima palavra mais provável em suas respostas.

Além disso, o Anthropic emprega aprendizado por reforço com feedback humano (RLHF) para ajustar o modelo, tornando suas respostas mais naturais e úteis.

Um diferencial importante para Claude é o uso de IA constitucional, um método exclusivo de ajuste fino em que princípios éticos orientam as saídas do modelo. O processo envolve:

- Definição de uma constituição: um modelo de IA recebe uma lista de princípios e exemplos de respostas que aderem ou violam esses princípios.

- Autoavaliação e correção: um segundo modelo de IA avalia o quão bem o primeiro modelo segue sua constituição e corrige suas respostas quando necessário.

Por exemplo, se solicitado a fornecer informações antiéticas, Claude pode inicialmente obedecer. No entanto, após a autoavaliação, ele identifica as questões éticas e revisa sua resposta de acordo.

O que a IA Claude pode fazer?

Claude pode executar uma ampla gama de tarefas, tornando-se uma ferramenta versátil para uso pessoal e profissional. Alguns dos recursos incluem:

- Responder perguntas: Claude pode fornecer respostas detalhadas e precisas às dúvidas dos usuários sobre vários tópicos.

- Revisão e edição: a IA pode revisar e sugerir melhorias para conteúdo escrito, incluindo cartas de apresentação, currículos, ensaios e muito mais.

- Escrita criativa: os usuários podem pedir a Claude para escrever letras de músicas, contos ou até mesmo planos de negócios.

- Tradução de idiomas: Claude pode traduzir texto para diferentes idiomas, tornando-o uma ferramenta útil para comunicação internacional.

- Descrição de imagem: Claude pode descrever imagens e sugerir receitas com base em fotos de comida.

- Resumo: a IA pode resumir documentos longos, incluindo PDFs, documentos do Word, fotos e gráficos, fornecendo informações concisas e relevantes.

- Aplicativos comerciais: Claude pode ajudar a elaborar estratégias de negócios, automatizar processos de vendas e recuperar conhecimento rapidamente.

Apesar de seus muitos recursos, Claude tem algumas limitações. A Anthropic alerta que Claude pode gerar respostas irrelevantes, imprecisas ou sem sentido, especialmente ao processar conteúdo vinculado.

Os usuários são encorajados a copiar e colar texto de páginas da web ou PDFs diretamente na caixa de bate-papo para obter resultados mais precisos.

Claude vs. ChatGPT: Como eles são diferentes?

Embora tanto o Claude quanto o ChatGPT sejam projetados para se envolver em conversas naturais, semelhantes às humanas, e executar uma variedade de tarefas, há várias diferenças importantes que os diferenciam:

- Capacidade de processamento: Claude pode processar cerca de 200.000 palavras por vez, em comparação com as 64.000 palavras do GPT-4 e as 25.000 palavras do GPT-3.5. Essa janela de contexto maior permite que seja manipulado documentos mais longos e mantenha mais contexto nas conversas.

- Desempenho em exames: os modelos Claude superam o GPT-3.5 em vários benchmarks de avaliação, incluindo conhecimento especializado e raciocínio. Isso indica que essa ferramenta pode fornecer respostas mais precisas e perspicazes em cenários complexos.

- Retenção de dados: diferentemente do ChatGPT, que retém dados do usuário para treinamento posterior, o Claude não armazena dados do usuário, aumentando a privacidade e a segurança dos dados.

- Segurança e ética: a abordagem constitucional de IA do Claude o torna melhor na produção de respostas seguras e éticas, reduzindo a probabilidade de gerar conteúdo prejudicial ou tóxico.

Como usar Claude.ai no Brasil?

Usar o Claude AI é simples. Você pode se inscrever para uma conta gratuita em claude.ai com um endereço de e-mail e número de telefone.

Depois de registrado, você pode iniciar uma conversa digitando um prompt ou enviando documentos para Claude resumir.

A versão gratuita fornece acesso ao modelo Claude 3.5 Sonnet, enquanto a versão Pro, disponível por US$ 20 por mês, oferece mais prompts por dia e acesso antecipado a novos recursos.

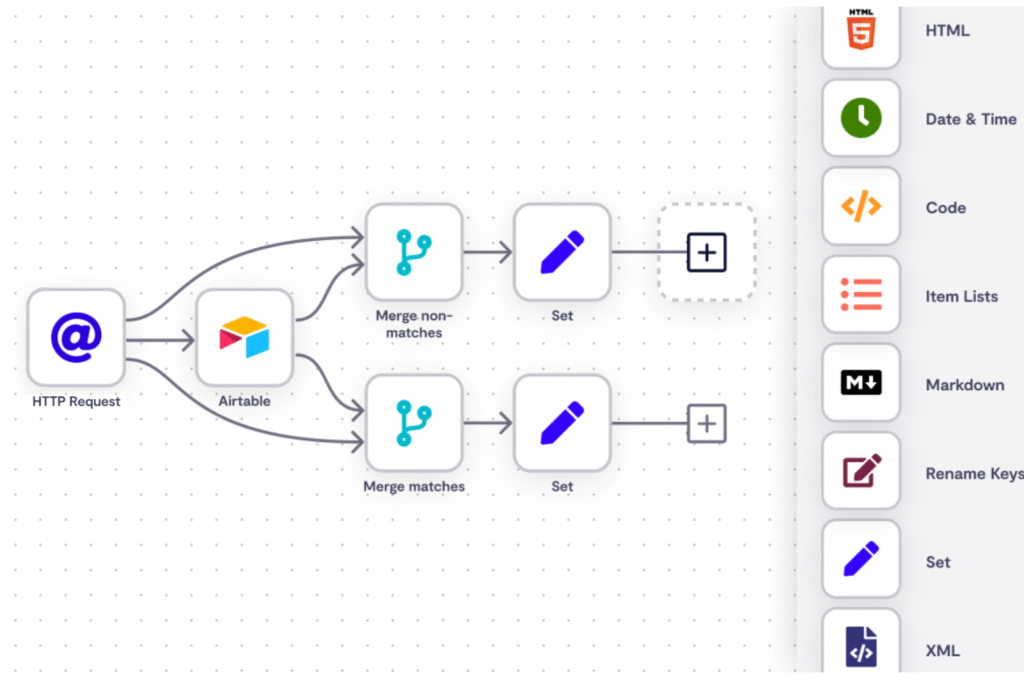

Para desenvolvedores e empresas que buscam integrar o Claude em seus sistemas, a Anthropic oferece acesso à API.

Isso permite a criação de soluções personalizadas que aproveitam os recursos avançados do Claude.

Além disso, os modelos podem ser acessados por meio do Amazon Bedrock e da plataforma Vertex AI do Google Cloud, fornecendo flexibilidade em como a IA é implantada e utilizada.

Perspectivas e desafios futuros

O campo da IA está avançando rapidamente, e tanto Claude quanto ChatGPT estão na vanguarda desses desenvolvimentos.

Assim, à medida que os modelos de IA se tornam mais sofisticados, a demanda por IA ética e responsável aumenta.

O foco da Anthropic em segurança e ética posiciona sua ferramenta como um líder neste espaço, mas os desafios permanecem.

Um dos desafios contínuos para desenvolvedores de IA é equilibrar as compensações entre complexidade do modelo, desempenho e segurança.

Portanto, à medida que os modelos de IA crescem em tamanho e capacidade, garantir que eles permaneçam seguros e confiáveis se torna cada vez mais difícil.

Estruturas regulatórias e padrões da indústria também estão evoluindo, exigindo que as empresas de IA fiquem à frente de considerações legais e éticas.

Além disso, a competição entre desenvolvedores de IA como Anthropic e OpenAI impulsiona a inovação contínua.

Assim, essa “corrida pela segurança”, conforme descrita pelo cofundador da Anthropic, Ben Mann, é um desenvolvimento positivo para a indústria, encorajando as empresas a priorizar considerações éticas em seus sistemas de IA.

Claude AI, desenvolvido pela Anthropic, é uma alternativa poderosa e eticamente orientada ao ChatGPT. Com seu desempenho superior, privacidade e foco em segurança e ética, essa nova ferramenta está bem posicionado para desafiar o domínio da OpenAI no mercado de chatbot de IA.

À medida que o campo da IA continua a evoluir, a abordagem inovadora da Anthropic para a segurança e responsabilidade da IA pode definir novos padrões para a indústria.

Para usuários e organizações que buscam uma ferramenta de IA confiável, segura e eticamente fundamentada, Claude oferece uma opção atraente.

Assim, seja para uso pessoal, aplicações comerciais ou pesquisa acadêmica, os recursos avançados e a estrutura ética o tornam uma escolha de destaque no cenário de IA lotado.

À medida que a Anthropic continua a refinar e expandir suas ofertas de IA, o futuro parece promissor para Claude e a comunidade de IA mais ampla.

Pronto para alavancar o poder da IA para o seu negócio? Descubra o potencial da IA sem a necessidade de experiência em codificação!

Visite a No Code Startup para explorar soluções inovadoras e transformar suas ideias em realidade com facilidade. Portanto, não perca a oportunidade de transformar seu negócio com tecnologia de IA de ponta hoje mesmo!

Leitura complementar: