Created by OpenAI rival Anthropic, Claude is a “helpful, harmless and honest” chatbot with a built-in ethical makeup.

With its unique approach to AI safety and ethics, Claude is emerging as a strong competitor to ChatGPT, offering several distinct advantages.

In this article, we’ll dive deeper into what Claude AI is, how it compares to ChatGPT, and what makes it stand out in the rapidly evolving field of AI chatbots.

What is Claude AI?

Claude is an artificial intelligence chatbot developed by Anthropic, a major AI startup that has received substantial funding from tech giants like Google and Amazon.

Anthropic's mission is to create AI systems that are more useful, harmless, and honest, while prioritizing accountability, ethics, and overall safety.

Claude is designed to generate text content and engage in natural, human-like conversations with users.

It can respond to text or image-based input and is accessible via the web or a mobile app.

AI is trained to handle a variety of tasks, including summarization, editing, Q&A, decision making, and more.

Anthropic offers a suite of three AI models under the Claude brand, each with unique capabilities:

- Claude 3 Opus: This model excels at handling complex tasks and open-ended prompts with remarkable fluency and human understanding.

- Claude 3.5 Sonnet: Designed for speed, this template is ideal for tasks that require quick responses, such as knowledge retrieval or sales automation.

- Claude 3 Haiku: the fastest and most compact model, it can quickly process data-dense documents and respond to simple queries with unmatched speed.

How does it work?

Claude, like other large language models (LLMs), is trained on large amounts of text data, including Wikipedia articles, news stories, and books.

It uses unsupervised learning methods to predict the most likely next word in your answers.

Additionally, Anthropic employs reinforcement learning with human feedback (RLHF) to fine-tune the model, making its responses more natural and useful.

A key differentiator for Claude is the use of constitutional AI, a unique fine-tuning method in which ethical principles guide the model’s outputs. The process involves:

- Definition of a constitution: An AI model is given a list of principles and examples of responses that adhere to or violate those principles.

- Self-assessment and correction: a second AI model evaluates how well the first model follows its constitution and corrects its responses when necessary.

For example, if asked to provide unethical information, Claude may initially comply. However, after self-assessment, he identifies the ethical issues and revises his response accordingly.

What can AI Claude do?

Claude can perform a wide range of tasks, making it a versatile tool for both personal and professional use. Some of the features include:

- Answer questions: Claude can provide detailed and accurate answers to user queries on a variety of topics.

- Review and editing: AI can review and suggest improvements to written content, including cover letters, resumes, essays, and more.

- Creative writing: Users can ask Claude to write song lyrics, short stories, or even business plans.

- Language translation: Claude can translate text into different languages, making it a useful tool for international communication.

- Image Description: Claude can describe images and suggest recipes based on food photos.

- Summary: AI can summarize long documents, including PDFs, Word documents, photos, and graphs, providing concise and relevant information.

- Business Applications: Claude can help develop business strategies, automate processes sales and recover knowledge quickly.

Despite its many features, Claude does have some limitations. Anthropic warns that Claude may generate irrelevant, inaccurate, or meaningless responses, especially when processing linked content.

Users are encouraged to copy and paste text from web pages or PDFs directly into the chat box for more accurate results.

Claude vs. ChatGPT: How Are They Different?

While both Claude and ChatGPT are designed to engage in natural, human-like conversations and perform a variety of tasks, there are several key differences that set them apart:

- Processing capacity: Claude can process about 200,000 words at a time, compared to GPT-4’s 64,000 words and GPT-3.5’s 25,000 words. This larger context window allows it to handle longer documents and maintain more context in conversations.

- Exam performance: Claude models outperform GPT-3.5 on several evaluation benchmarks, including expert knowledge and reasoning. This suggests that this tool can provide more accurate and insightful answers in complex scenarios.

- Data retention: Unlike ChatGPT, which retains user data for later training, Claude does not store user data, increasing data privacy and security.

- Safety and ethics: Claude's constitutional AI approach makes it better at producing safe and ethical responses, reducing the likelihood of generating harmful or toxic content.

How to use Claude.ai in Brazil?

Using Claude AI It's simple. You can sign up for a free account at claude.ai with an email address and phone number.

Once registered, you can start a conversation by typing a prompt or sending documents for Claude to summarize.

The free version provides access to the Claude 3.5 Sonnet model, while the Pro version, available for US$14T20 per month, offers more prompts per day and early access to new features.

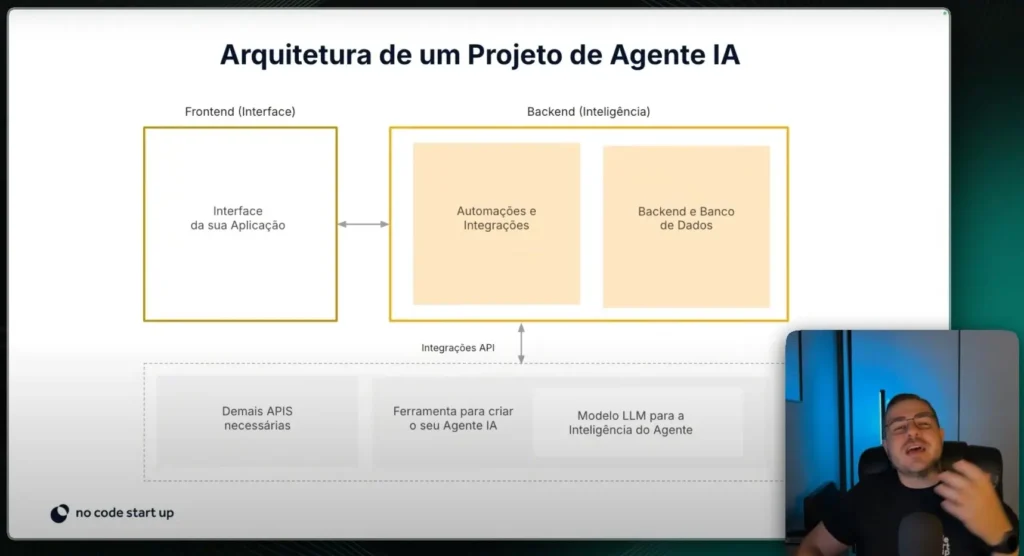

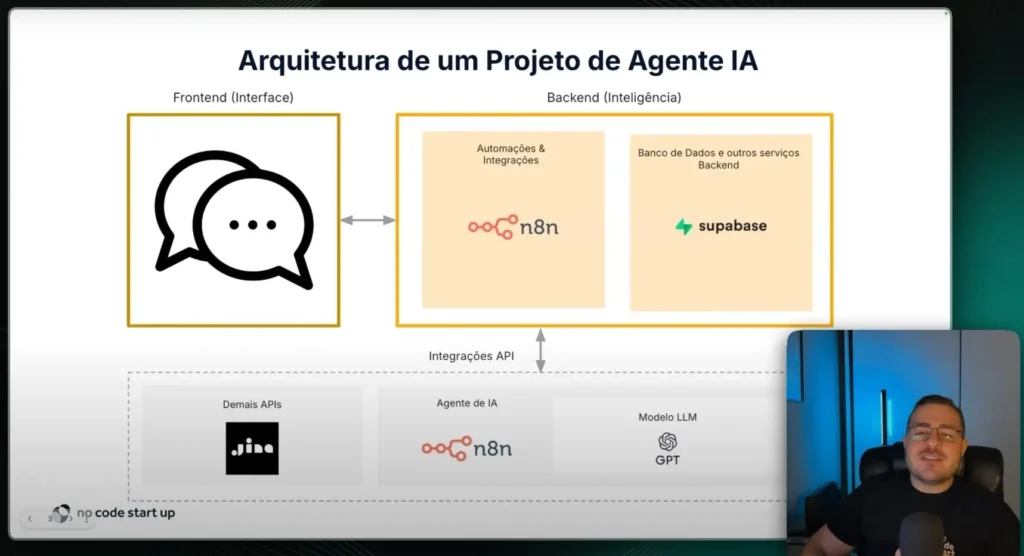

For developers and companies looking to integrate Claude into their systems, Anthropic offers API access.

This allows the creation of customized solutions that take advantage of Claude's advanced features.

Additionally, models can be accessed through Amazon Bedrock and Google Cloud’s Vertex AI platform, providing flexibility in how AI is deployed and utilized.

Future perspectives and challenges

The field of AI is advancing rapidly, and both Claude and ChatGPT are at the forefront of these developments.

So as AI models become more sophisticated, the demand for ethical and responsible AI increases.

Anthropic’s focus on safety and ethics positions its tool as a leader in this space, but challenges remain.

One of the ongoing challenges for AI developers is balancing the tradeoffs between model complexity, performance, and security.

Therefore, as AI models grow in size and capability, ensuring they remain safe and trustworthy becomes increasingly difficult.

Regulatory frameworks and industry standards are also evolving, requiring AI companies to stay ahead of legal and ethical considerations.

Additionally, competition between AI developers like Anthropic and OpenAI drives continued innovation.

So this “race to safety,” as described by Anthropic co-founder Ben Mann, is a positive development for the industry, encouraging companies to prioritize ethical considerations in their AI systems.

Claude AI, developed by Anthropic, is a powerful and ethically-minded alternative to ChatGPT. With its superior performance, privacy, and focus on security and ethics, this new tool is well-positioned to challenge OpenAI’s dominance in the AI chatbot market.

As the field of AI continues to evolve, Anthropic’s innovative approach to AI safety and accountability could set new standards for the industry.

For users and organizations looking for a reliable AI tool, safe and ethically grounded, Claude offers an attractive option.

So, whether for personal use, commercial applications, or academic research, its advanced features and ethical framework make it a standout choice in the crowded AI landscape.

As Anthropic continues to refine and expand its AI offerings, the future looks bright for Claude and the broader AI community.

Ready to leverage the power of AI for your business? Discover the potential of AI without the need for coding experience!

Visit the No Code Startup to explore innovative solutions and easily turn your ideas into reality. So don’t miss the opportunity to transform your business with cutting-edge AI technology today!

Further reading: