Generative AI is a cutting-edge branch of artificial intelligence that produces diverse types of content, including text, images, audio, and synthetic data.

Its recent surge in popularity stems from user-friendly interfaces that allow you to create high-quality content — text, graphics, and videos — in mere seconds.

Contents

Evolution of generative AI

However, the technology is not entirely new. It dates back to the 1960s with the development of the first chatbots.

The real breakthrough came in 2014 with the introduction of Generative Adversarial Networks (GANs), a machine learning algorithm capable of creating convincingly realistic images, videos, and audio.

Two significant developments have brought generative AI into the mainstream: transformers and the language models they enable.

Thus, transformers revolutionized machine learning by allowing researchers to train large models without having to pre-label all the data.

This innovation has led to more insightful responses from AI systems, capable of analyzing not just words but also complex data such as code, proteins, and even DNA.

Large language models (LLMs), boasting billions or trillions of parameters, have ushered in a new era of generative AI.

These templates can create engaging text, create photorealistic images, and even generate entertaining content.

Multimodal AI now enables the simultaneous generation of text, image, and video content.

Therefore, this innovation enhances tools such as DALL-E, which can produce images from textual descriptions or generate captions from images.

How does it work?

Generative AI works by responding to a prompt, whether it’s text, an image, a video, or even musical notes.

AI uses various algorithms to produce new content based on this input, such as essays, realistic fakes, or problem-solving solutions.

Thus, in its early stages, generative AI required developers to send data through APIs or use best tools specialized.

Today, the user experience has improved dramatically, allowing users to enter requests in plain language and receive personalized responses based on style, tone, and other preferences.

Generative AI models

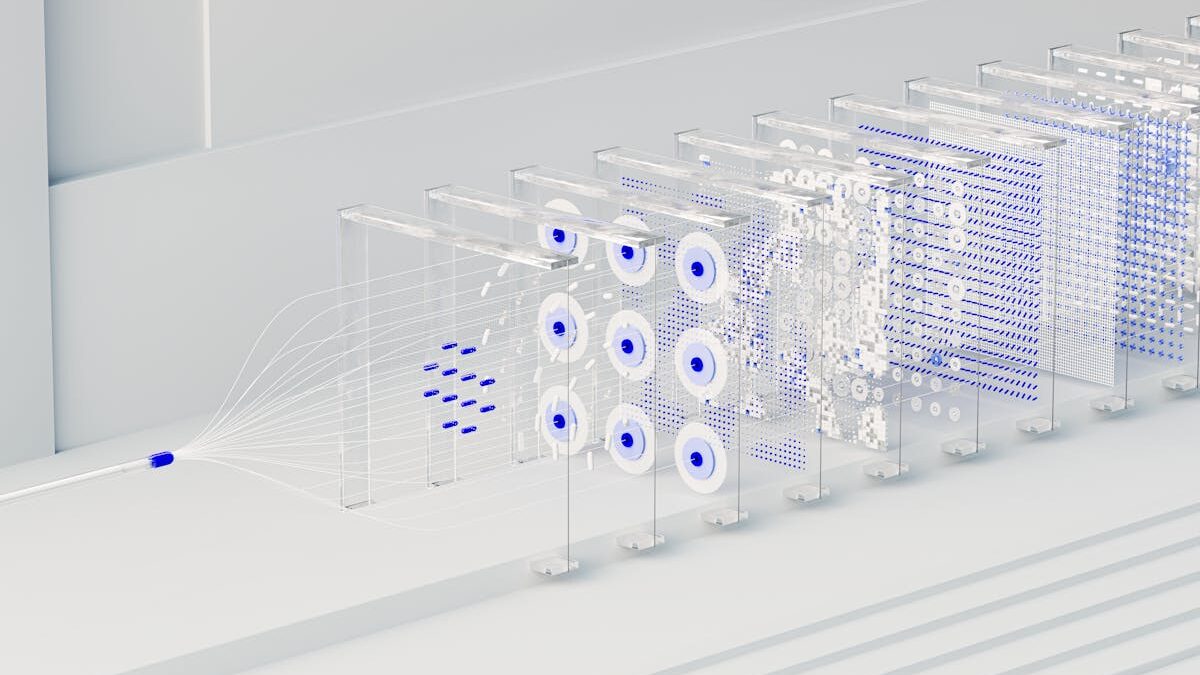

Generative AI models combine multiple algorithms to represent and process different types of content.

For example, to generate text, natural language processing techniques convert raw characters into sentences and actions, represented as vectors.

Similarly, images are divided into visual elements and processed as vectors.

However, it is essential to note that these models may encode biases, inaccuracies, or harmful content from the data they were trained on.

Once the data is represented, neural networks like GANs or variational autoencoders (VAEs) generate new content.

These models can then create realistic human faces, synthetic data to train AI systems, or even realistic representations of specific individuals.

Popular Generative AI Tools

Generative AI applications have gained widespread recognition, including:

- DALL-E: A multimodal AI model that links text descriptions to visuals, allowing users to generate images from written prompts.

- ChatGPT: Launched in November 2022 and built on GPT-3.5, this chatbot simulates natural conversations and allows for interactive feedback. GPT-4, released in March 2023, further improved its capabilities.

- Gemini: Developed by Google, Gemini uses transformative AI for language and content generation. While its initial launch faced challenges, its most recent iterations have improved efficiency and visual responses.

Use cases for generative AI

Generative AI can be applied in several fields, including:

- Creation of chatbots for customer service.

- Generating deepfakes for entertainment or potentially harmful purposes.

- Improve language dubbing in films and educational content.

- Writing emails, resumes, or essays.

- Design photorealistic art or new products.

- Optimize chip design and suggest new drug compounds.

- Compose music in specific styles.

Benefits

Generative AI offers significant advantages, such as:

- Automate content creation processes.

- Simplify email responses and technical queries.

- Generate realistic representations of people and summarize complex information into coherent narratives.

- Simplify the creation of content in specific styles and tones.

Limitations

While generative AI holds great promise, it also brings challenges:

- It does not always provide sources for content, making verification difficult.

- It can reflect biases and prejudices present in your training data.

- Content that appears realistic can obscure inaccuracies.

- Tuning AI models for specific scenarios can be complex.

Generative vs. Generative AI Traditional AI

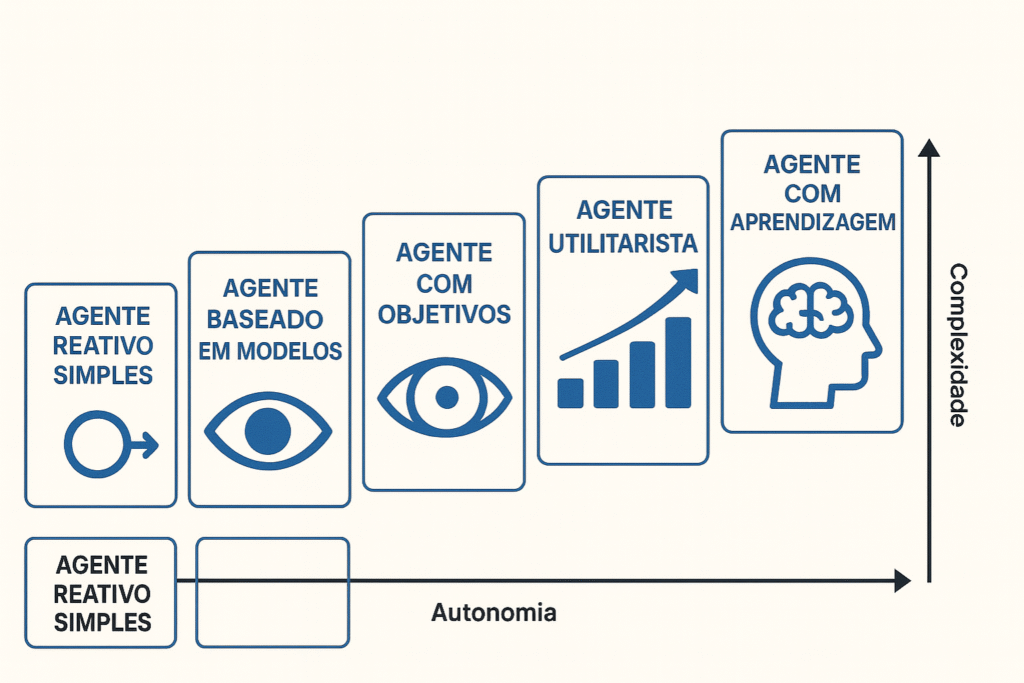

Generative AI focuses on creating new content and solutions based on user prompts. It relies on neural networks like transformers, GANs, and VAEs.

In contrast, traditional AI typically follows predefined rules to process data, making it better suited for tasks that involve structured outputs.

What is the future of generative AI?

Generative artificial intelligence has gone from being a promising trend to becoming a concrete revolution in the global innovation scenario.

Tools like ChatGPT, DALL·E, Midjourney, and Claude have driven digital transformation in areas like education, marketing, healthcare, software development, and content creation.

By 2025, generative AI is already deeply integrated into productivity platforms and work environments, automating creative tasks, streamlining customer service, and expanding the personalization of products and services.

According to reports from McKinsey and Gartner, it is estimated that by 2030, more than 70% of companies will use generative AI as part of their core operations.

Beyond automation, the focus is now shifting to AI governance and ethics: regulations are emerging to track the origin of AI-generated content, ensure its veracity, and prevent deepfakes or data manipulation.

Solutions of content provenance and digital watermarks are being implemented by companies like OpenAI and Google DeepMind.

The future points to the decentralization and democratization of this technology.

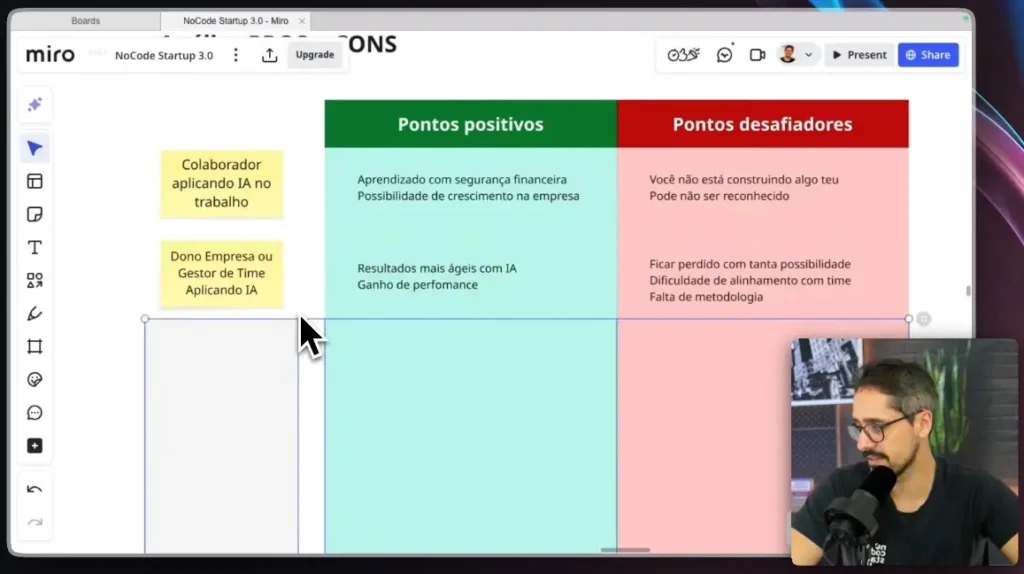

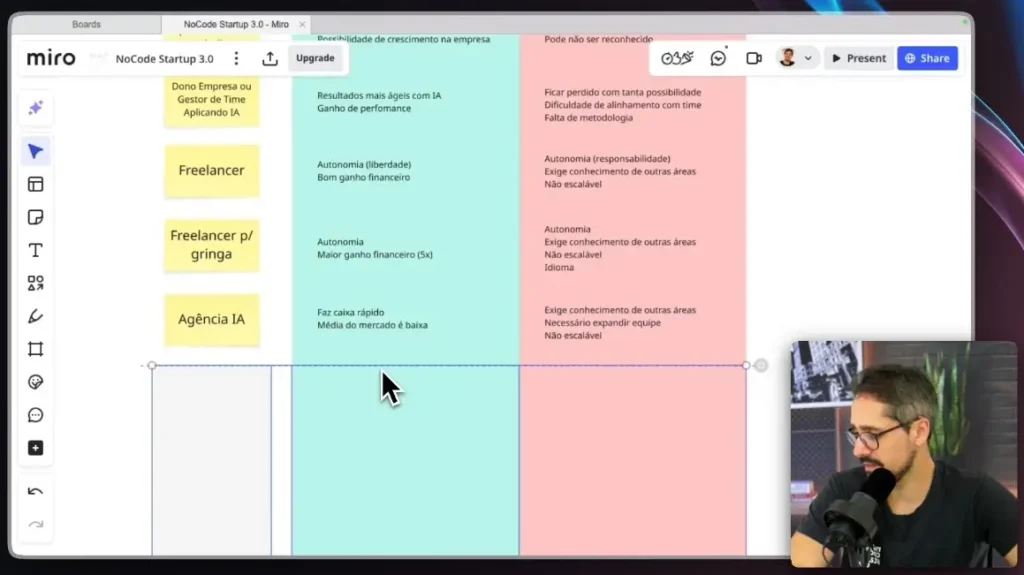

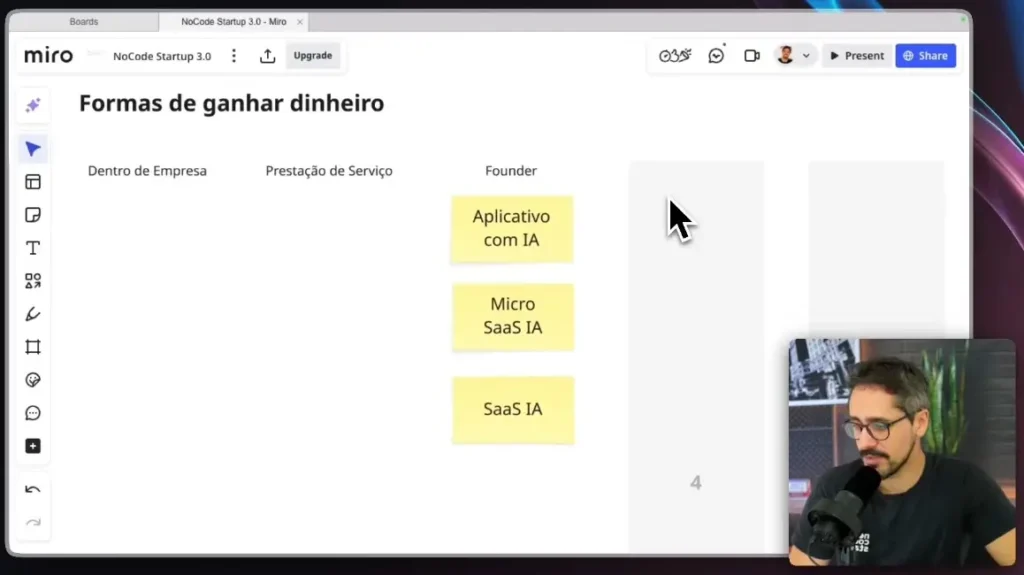

With NoCode and LowCode platforms, small businesses and freelancers are already creating smart solutions without the need to program.

No-code AI training has become a strategic bridge to innovate with agility and low cost.

The impact of generative AI goes beyond productivity — it is redefining the very notion of human expertise.

Traditional professions are being reshaped, requiring hybrid skills such as critical thinking, data curation, and prompt engineering.

Want to learn how to apply the best AI tools without writing a line of code? Discover our NoCodeIA Training and start innovating right now.