A rápida ascensão e a crescente autonomia dos Modelos de Linguagem Grandes (LLMs) transformaram radicalmente o panorama tecnológico.

No ecossistema No-Code/Low-Code, onde a velocidade de implementação é um diferencial competitivo crucial, a segurança e a previsibilidade desses modelos tornaram-se uma preocupação central.

Entra em cena o framework IA Petri da Anthropic, um sistema de código aberto projetado para resolver o maior desafio da segurança de IA moderna: a escala.

O IA Petri não é apenas mais uma ferramenta de teste; é uma mudança de paradigma que substitui os ineficientes benchmarks estáticos por um modelo de auditoria automatizada de IA baseado em agentes inteligentes, oferecendo uma garantia agêntica que é essencial para qualquer startup que deseja escalar suas soluções com confiança.

O Problema de Escala na Segurança de IA: Por Que Benchmarks Estáticos Falharam

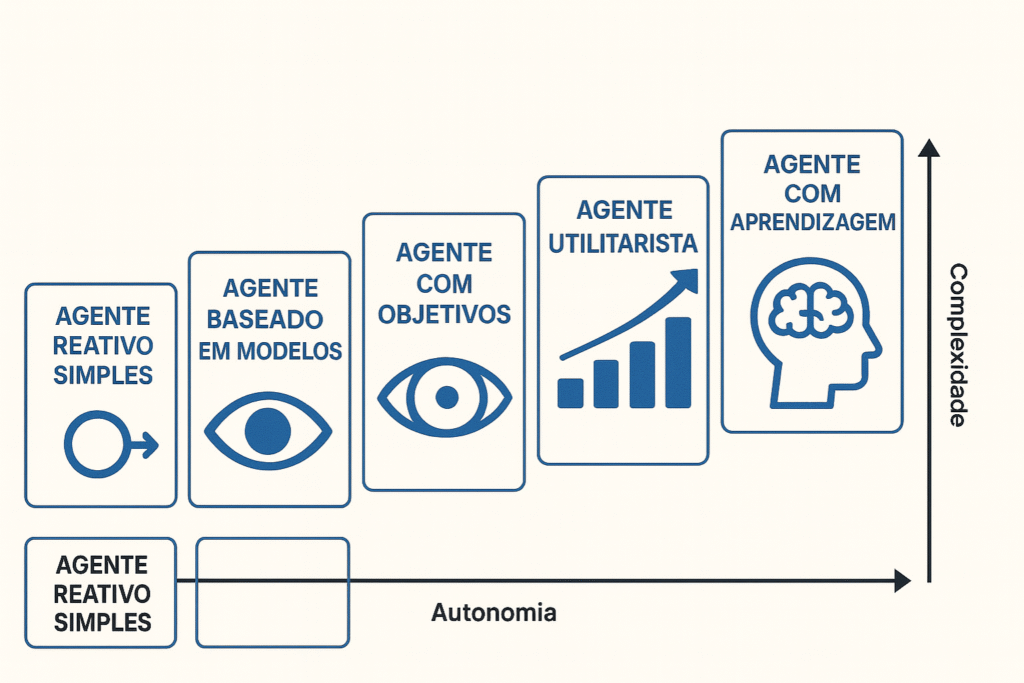

À medida que os LLMs avançam em capacidade e se tornam cada vez mais autônomos – capazes de planejar, interagir com ferramentas e executar ações complexas – a superfície de risco se expande exponencialmente.

Esse crescimento impõe uma pressão insustentável sobre os métodos de avaliação de segurança tradicionais.

A Inadequação do Red Teaming Manual na Era dos LLMs Complexos

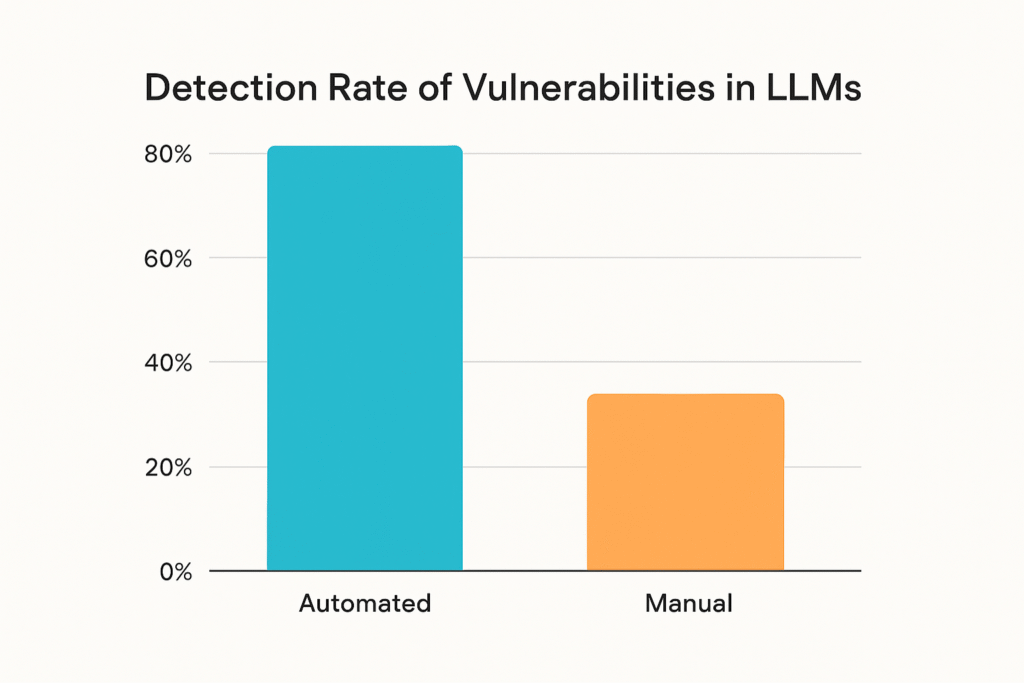

Historicamente, a avaliação de segurança de LLMs dependia majoritariamente do red teaming manual: equipes de especialistas que tentam, ativamente, “quebrar” ou explorar o modelo.

Embora essa abordagem seja inestimável para investigações profundas, ela é, por natureza, lenta, intensiva em mão de obra e, o mais importante, não escalável.

O volume colossal de comportamentos possíveis e as combinações de cenários de interação superam em muito o que qualquer equipe humana pode testar de forma sistemática.

A limitação reside na repetibilidade e na abrangência. Os testes manuais são frequentemente específicos de um cenário e difíceis de replicar em novos modelos ou versões.

Em um ciclo de desenvolvimento Low-Code, onde as iterações são rápidas e frequentes, confiar apenas em auditorias pontuais e demoradas cria uma lacuna de segurança que pode ser explorada.

A auditoria automatizada de IA se apresenta, portanto, não como uma opção, mas como uma necessidade técnica para acompanhar a velocidade da inovação.

Comportamentos Emergentes e a Superfície de Ataque Exponencial

Modelos de IA, especialmente os mais avançados, exibem comportamentos emergentes de IA.

Isso significa que a interação de suas complexas redes neurais pode resultar em capacidades ou vulnerabilidades que não foram explicitamente treinadas ou previstas.

É essa natureza imprevisível que torna os benchmarks estáticos – testes pré-definidos com um conjunto fixo de perguntas e respostas – obsoletos.

Eles apenas testam o que já sabemos, deixando de lado o vasto espaço de “desconhecido desconhecido”.

A superfície de ataque para desalinhamento – onde o modelo age de maneiras prejudiciais ou não intencionais – cresce em proporção direta à sua capacidade e autonomia.

O IA Petri foi concebido precisamente para abordar essa natureza dinâmica, utilizando a própria inteligência artificial (agentes) para interrogar o Modelo Alvo (Target Model) de forma criativa e sistemática, simulando as interações complexas do mundo real.

A Arquitetura Agêntica do IA Petri: Componentes e a Dinâmica da Auditoria

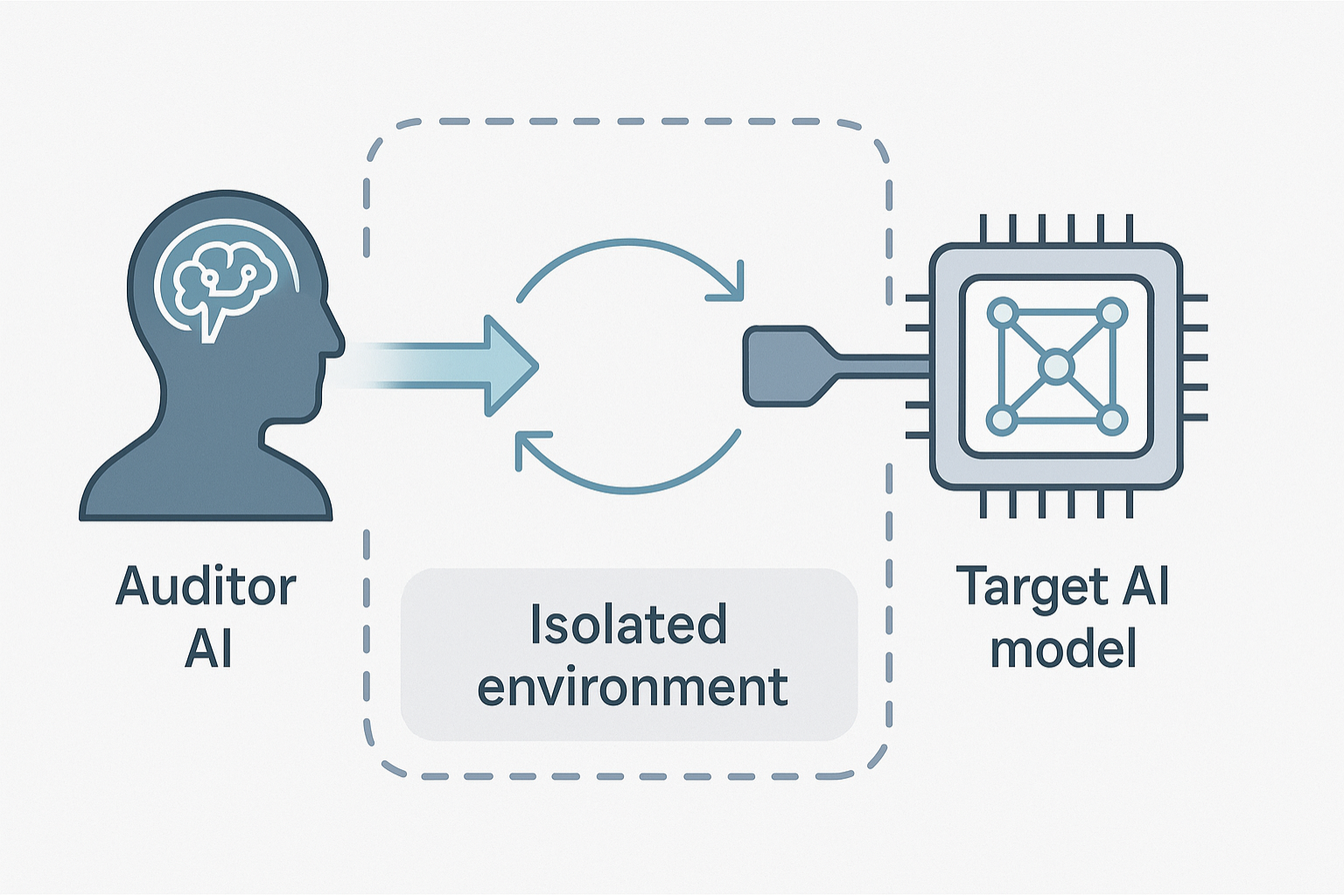

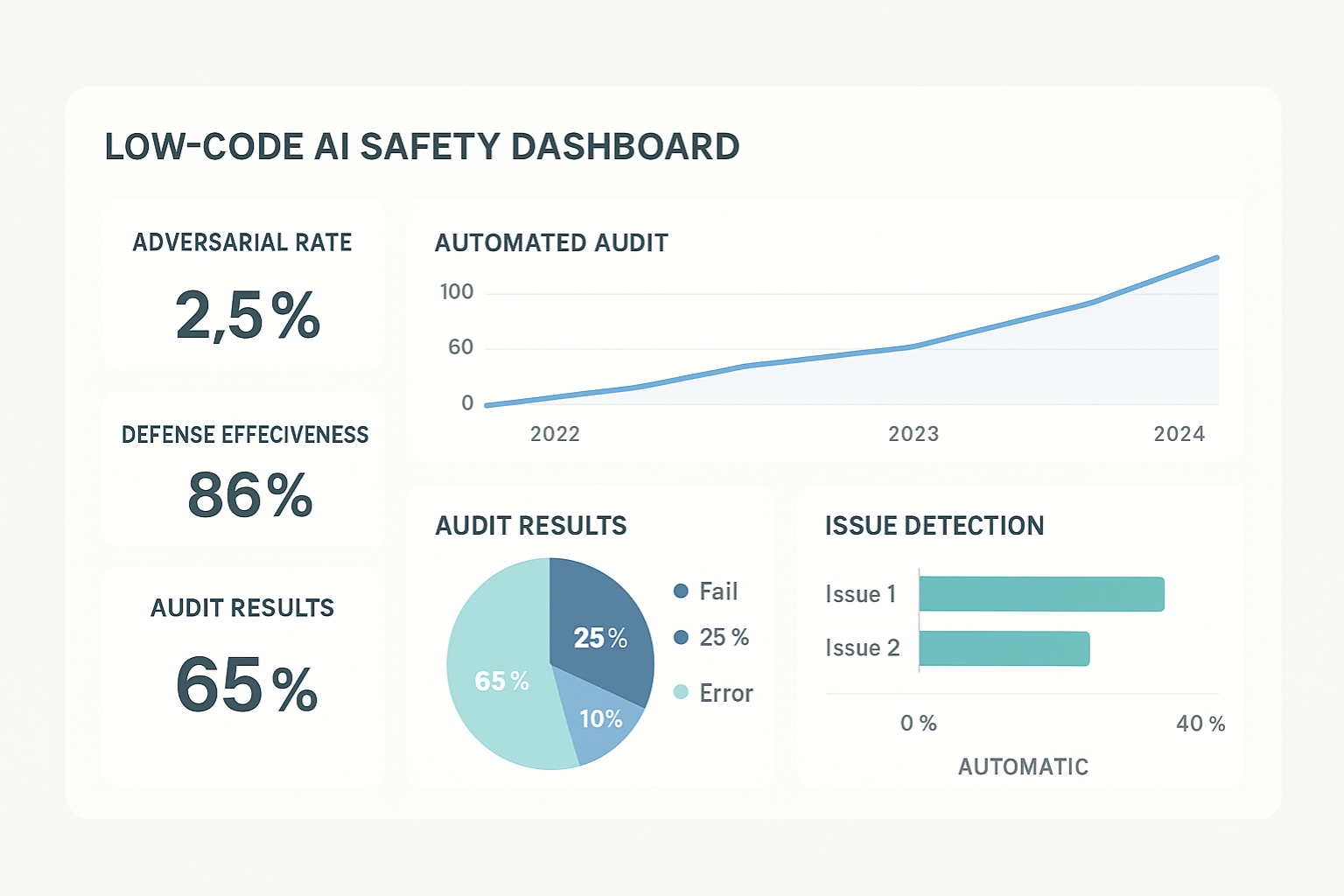

O IA Petri funciona como um ecossistema de avaliação onde o modelo a ser auditado é colocado em um ambiente controlado e desafiado por um agente adversário.

A sofisticação desse framework reside na separação de responsabilidades em componentes modulares e interconectados, o que o torna uma solução de framework de segurança agêntica altamente estruturada, detalhada em seu artigo de pesquisa (The Agentic Oversight Framework).

O Modelo Alvo (Target Model) e a Necessidade de Avaliação Contínua

O Modelo Alvo é o LLM que está sendo testado. Ele pode ser qualquer modelo, desde o Claude da própria Anthropic até um modelo de código aberto integrado em um fluxo de trabalho Low-Code.

A beleza do IA Petri é sua capacidade de realizar avaliação dinâmica de LLMs. Em vez de um teste post-mortem, ele permite uma auditoria contínua e em tempo real, crucial para equipes que estão constantemente implantando e ajustando suas aplicações.

O Agente Auditor e o Motor de Cenários (Scenarios Engine): O Coração do Teste Dinâmico

Aqui reside o poder da IA Petri. O Agente Auditor é um LLM mais simples, dedicado e especializado em testar os limites do Modelo Alvo.

Ele não é apenas um testador passivo; ele age como um red teamer (adversário) autônomo, gerando sequências de interações maliciosas ou de desalinhamento de forma estratégica.

O Motor de Cenários (Scenarios Engine) é responsável por estruturar os testes, garantindo que o Agente Auditor explore uma ampla gama de vetores de ataque, desde injeção de prompt até tentativas de geração de informações proibidas.

Essa dinâmica permite uma exploração muito mais profunda e replicável do que qualquer teste manual, conforme detalhado no lançamento oficial da ferramenta (Anthropic AI Lança Petri: Um Framework de Código Aberto).

O Ambiente (Environment) Controlado: Garantindo a Reprodutibilidade dos Testes

O Ambiente é o contexto simulado onde a interação acontece. Ele é fundamental para a ciência da avaliação de IA, pois permite que os mesmos testes sejam executados com precisão em diferentes modelos ou em diferentes iterações do mesmo modelo.

Essa capacidade de reprodutibilidade é um marco para a segurança de modelos de IA, permitindo que as equipes de desenvolvimento Low-Code incorporem os resultados da auditoria diretamente em seus pipelines de CI/CD (Integração Contínua/Entrega Contínua).

Para entender melhor como estruturar a base tecnológica para esses sistemas, você pode aprofundar-se em O que é infraestrutura de IA e por que ela é essencial.

Red Teaming Automatizado e o Conceito de Garantia Agêntica com a IA Petri

A IA Petri eleva o conceito de red teaming ao automatizá-lo com agentes de IA.

O objetivo final é a Garantia Agêntica, ou seja, ter confiança de que um modelo manterá seu alinhamento de modelos de linguagem e segurança, mesmo sob estresse, sem a necessidade de intervenção humana constante.

IA Petri vs. Ferramentas de Avaliação Comuns (DeepEval, Garak): Uma Comparação Técnica

Existem excelentes ferramentas de código aberto no espaço de avaliação de LLMs. Ferramentas como o Garak e o DeepEval oferecem capacidades robustas para escanear vulnerabilidades, realizar fuzzing ou avaliar a qualidade da saída do modelo.

O paper acadêmico que descreve o Garak, por exemplo, foca na sondagem de segurança de LLMs. Outras ferramentas, como as listadas entre os Top 5 Open-Source AI Red-Teaming Tools, complementam o ecossistema.

O repositório GitHub do DeepEval também demonstra o foco em métricas de avaliação.

Enquanto DeepEval pode focar na avaliação de métricas e Garak na descoberta de vulnerabilidades conhecidas, o IA Petri utiliza a própria inteligência de um agente adversário para gerar ativamente novos vetores de ataque e explorar falhas que não estão em nenhuma lista de verificação preexistente.

Ele simula, de fato, a intenção maliciosa, escalando o Red Teaming de LLMs para um novo patamar de sofisticação.

Geração de Cenários Complexos: Testando o Alinhamento e a Segurança de Modelos de Linguagem

A principal característica do framework é sua capacidade de gerar automaticamente cenários de teste que abrangem uma vasta gama de riscos de segurança de IA, incluindo:

- Geração de Conteúdo Perigoso: Tentativas de fazer o modelo produzir instruções para atividades ilegais ou prejudiciais.

- Vazamento de Dados: Explorar vulnerabilidades para extrair informações sensíveis do modelo.

- Desalinhamento Instrucional: Garantir que o modelo não persiga objetivos não intencionais ou perigosos, mesmo quando instruído para fazê-lo por um usuário, um ponto central discutido no artigo que fundamenta o framework de Garantia Agêntica.

O Agente Auditor se adapta e aprende com as respostas do Modelo Alvo, tornando a auditoria um processo iterativo e de “caça” contínua.

Tipos de Vulnerabilidades Descobertas e a Importância do Open-Source

Desde o seu lançamento, o IA Petri têm demonstrado a capacidade de descobrir falhas sutis que passariam despercebidas por métodos tradicionais, reforçando a urgência de uma abordagem dinâmica.

O fato de ser um projeto open-source (conforme anunciado no lançamento do Petri pela Anthropic) permite que a comunidade global de segurança de IA colabore na definição e na execução de cenários, acelerando a mitigação de vulnerabilidades em todos os modelos.

Essa transparência é vital para a confiança no ecossistema de IA.

Aplicação Prática para Desenvolvedores No-Code/Low-Code: Integrando a Segurança Dinâmica

Para o desenvolvedor Low-Code ou o líder de startup na No Code Start Up, a questão não é apenas teórica: é como traduzir essa tecnologia avançada em produtos mais confiáveis.

Mitigando Riscos em Aplicações Autônomas e Agentes de IA

A maior relevância do IA Petri está na construção de Agentes de IA e aplicações autônomas.

Quando um agente recebe a capacidade de interagir com o mundo real (como enviar e-mails, processar pagamentos ou gerenciar tarefas), a falha de alinhamento se transforma de um erro de texto em uma falha operacional de alto risco.

Ao incorporar princípios de auditoria automatizada de IA como o IA Petri, os desenvolvedores Low-Code podem testar seus agentes sob estresse antes da implantação, garantindo que a automação siga as regras de negócio e os limites de segurança predefinidos.

Se a sua startup está explorando a criação de workflows sofisticados ou novos Agentes de IA e Automação: Solução NoCode para Empresas, a auditoria dinâmica é indispensável.

Estratégias de Desenvolvimento Seguro e a Cultura de Testes Contínuos na Prática

Integrar a segurança de LLMs não é um passo único; é uma cultura. A adoção de frameworks como o IA Petri exige que as equipes Low-Code pensem na segurança desde o início do projeto, e não apenas no final.

- Validação de Prompts e Saídas: Use o IA Petri para testar a robustez de seus prompts e a segurança das saídas em diferentes versões de modelos.

- Teste de Regressão: Após cada ajuste fino (fine-tuning) ou atualização do modelo, o framework pode ser executado para garantir que as correções de segurança não introduzam novos problemas (regressão de segurança).

Para quem busca dominar a criação de soluções robustas e seguras com IA, a base está na Formação AI Coding: Crie Apps com IA e Low-Code, que enfatiza a integração de práticas de desenvolvimento seguro.

O Papel da Infraestrutura de IA na Adoção de Frameworks como Petri

A execução eficiente de testes complexos e em escala, como os realizados pelo IA Petri, requer uma infraestrutura de IA robusta e escalável.

As startups precisam de sistemas que possam gerenciar múltiplos modelos, orquestrar agentes auditores e processar grandes volumes de dados de teste de forma econômica.

Investir em uma infraestrutura adequada não é apenas sobre velocidade, mas sim sobre possibilitar a adoção dessas ferramentas de ponta para elevar o padrão de segurança e de desenvolvimento Low-Code.

A Evolução da Segurança de Modelos: O Futuro da IA Petri e o Movimento Open-Source

O lançamento do IA Petri pela Anthropic não é um ponto final, mas um catalisador para a próxima fase da segurança de IA.

Seu impacto se estende além da detecção de falhas, moldando a própria filosofia de como o alinhamento de modelos de linguagem deve ser alcançado e mantido.

Colaboração Comunitária e a Moldagem do Padrão de Alinhamento Global

Como código aberto, o IA Petri se beneficia da sabedoria coletiva. Pesquisadores, empresas de segurança e até mesmo entusiastas Low-Code/No-Code podem contribuir com novos cenários de teste (Petri Scenarios), identificando e formalizando vetores de ataque únicos.

Essa colaboração garante que o framework se mantenha à frente dos novos comportamentos emergentes de IA e se torne o padrão da indústria para avaliação de modelos. A força da comunidade é a única maneira de combater a complexidade crescente do Red Teaming de LLMs.

Preparando-se para a Governança de IA: O IA Act e a Auditoria Preventiva

À medida que a Governança de IA se torna uma realidade global – com regulamentações como o EU AI Act exigindo níveis crescentes de transparência e segurança – a capacidade de demonstrar a robustez de um modelo será um requisito legal e de mercado.

O IA Petri fornece às organizações, incluindo startups No-Code, um mecanismo defensável para realizar auditorias preventivas, gerar documentação de teste completa e comprovar que seus sistemas foram rigorosamente avaliados contra riscos de desalinhamento e uso indevido (Agentic Assurance Framework).

O uso de um framework de segurança agêntica não é apenas uma boa prática técnica; é um investimento em conformidade futura.

Ao dominar ferramentas como o IA Petri, os desenvolvedores Low-Code se posicionam como líderes na construção de soluções de IA responsáveis e seguras.

FAQ: Perguntas Frequentes sobre a Auditoria de LLMs

Q1: Qual é o principal objetivo do framework IA Petri?

O principal objetivo do IA Petri é automatizar o processo de auditoria de segurança de Modelos de Linguagem Grandes (LLMs).

Ele utiliza agentes de IA (o Agente Auditor) para interagir dinamicamente com o Modelo Alvo, gerando cenários de teste complexos e em larga escala para descobrir e mitigar comportamentos emergentes de IA e riscos de desalinhamento que seriam perdidos em testes manuais ou benchmarks estáticos.

Q2: Como o IA Petri se diferencia do Red Teaming humano?

O red teaming humano é qualitativo, aprofundado e focado em um conjunto limitado de vetores de ataque.

O IA Petri é quantitativo, escalável e contínuo. Ele automatiza e expande o processo, permitindo que milhões de interações sejam testadas rapidamente e de forma repetível, superando o problema de escala inerente à avaliação manual de LLMs complexos.

Ele não substitui o ser humano, mas o amplia drasticamente.

Q3: IA Petri pode ser usado em qualquer Modelo de Linguagem Grande?

Sim, o IA Petri foi projetado para ser modular e agnóstico em relação ao modelo. Ele trata o LLM em auditoria (o Modelo Alvo) como uma caixa preta ou branca, interagindo com ele por meio de prompts e observando seu comportamento no Ambiente controlado.

Isso o torna aplicável a qualquer Modelo de Linguagem Grande que possa ser orquestrado dentro de um ambiente de teste, seja ele um modelo proprietário ou um modelo de código aberto.

Para a comunidade Low-Code Start Up, isso significa a chance de construir sistemas autônomos com um nível de confiança nunca antes alcançado.

A garantia de que seu produto se comporta de forma previsível e alinhada não é mais um ideal, mas uma realidade auditável.

O futuro da construção de softwares robustos, impulsionados pela inteligência artificial, reside na capacidade de integrar a auditoria automatizada de IA de forma nativa.

O IA Petri é o mapa, e agora cabe a você dar o próximo passo para dominar esta nova fronteira de segurança e inovação.

Se você busca não apenas criar, mas garantir a solidez e o alinhamento de seus próprios agentes de IA, explore a Formação AI Coding: Crie Apps com IA e Low-Code e eleve o padrão de segurança das suas soluções.