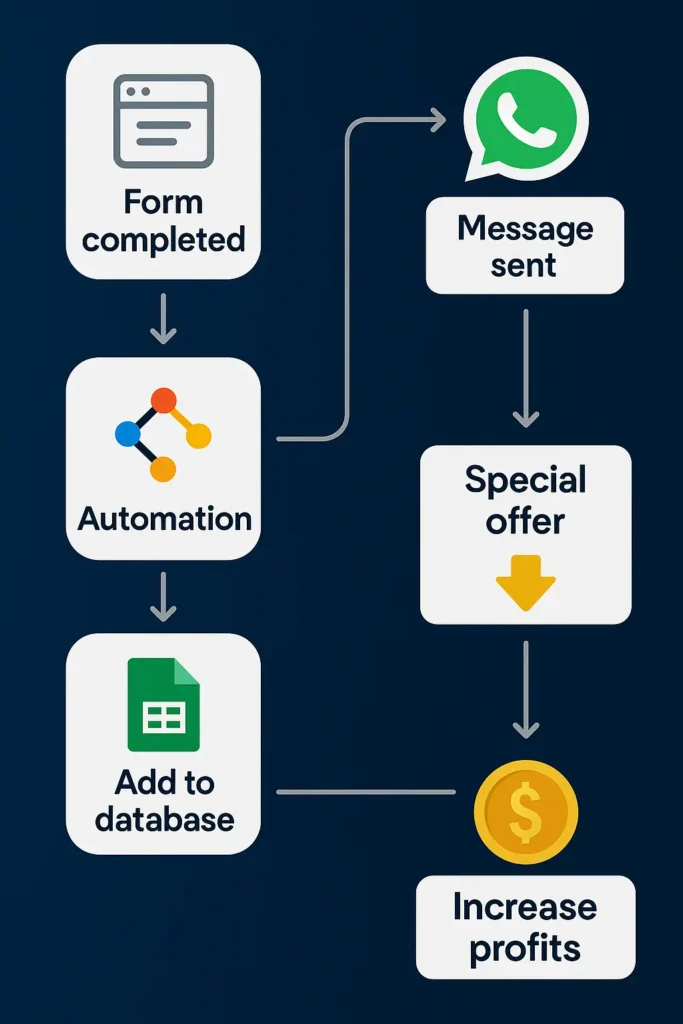

Você pode criar agentes de IA sem programar. As ferramentas no‑code tornaram isso acessível para quem não é técnico.

Não é preciso saber programar: o fluxo visual resolve integrações, lógica e publicação.

Neste artigo, vamos mergulhar nesse universo fascinante dos agentes de IA e mostrar como você pode usá-los, mesmo sem conhecimentos técnicos avançados.

Vamos explorar ferramentas que são amigáveis tanto para novatos quanto para profissionais mais experientes. Além disso, vamos destacar as diferenças cruciais entre agentes de IA e chatbots, ajudando você a escolher a melhor opção para o seu projeto.

Prepare-se para descobrir como potencializar suas iniciativas com tecnologia de ponta, de maneira simples e eficaz. Ficou curioso? Continue lendo e saiba tudo sobre esse tema empolgante.

Categorias de Ferramentas No-Code para IA

Construir agentes de inteligência artificial (IA) ficou mais fácil com o avanço das ferramentas No-Code.

Essas ferramentas são ideais para quem não tem conhecimento técnico aprofundado em programação, mas quer criar um produto inovador. Vamos entender como essas ferramentas podem ser úteis e acessíveis.

Ferramentas de Processamento de Linguagem Natural (PLN)

Elas são essenciais para que os agentes de IA compreendam e reajam a linguagem humana.

Com essas ferramentas, você pode criar sistemas que interagem e compreendem os usuários de forma natural. Imagine desenvolver um assistente virtual que responde a perguntas frequentes de clientes, como o Chatbase ou utilizando o GPT-o3, o modelo mais recente da OpenAI.

O o3 é o modelo de raciocínio mais poderoso da OpenAI, com desempenho multimodal (especialmente em visão) capaz de analisar imagens, gráficos e arquivos e sustentar decisões passo a passo, deixando fluxos de atendimento mais precisos e confiáveis.

Ferramentas de Desenvolvimento de Fluxo de Conversação

Fácil e Intuitivo (Ideal para Iniciantes)

ManyChat: Oferece uma interface intuitiva com editor visual de arrastar e soltar, ideal para iniciantes. Permite criar chatbots para Facebook Messenger, WhatsApp, SMS e e-mail. Possui um plano gratuito com recursos básicos e planos pagos a partir de US$ 15/mês.

Landbot: Plataforma visual que permite criar chatbots para web, WhatsApp e Facebook Messenger. Oferece modelos prontos e lógica condicional. Possui um plano gratuito com 100 chats/mês e planos pagos a partir de €40/mês.

Wati: Especializada em automação para WhatsApp, permite criar chatbots sem código com fluxos lógicos intuitivos. Oferece um teste gratuito de 7 dias.

Moderadamente Intuitivo (Requer Alguma Experiência)

Chatfuel: Permite criar chatbots para Facebook Messenger, WhatsApp e Instagram. Oferece modelos prontos e integração com IA. Possui um plano gratuito com funcionalidades limitadas e planos pagos a partir de US$ 15/mês.

HubSpot Chatbot Builder: Integrado ao CRM da HubSpot, permite criar chatbots para qualificação de leads e atendimento ao cliente. Oferece um plano gratuito com recursos básicos e planos pagos com funcionalidades avançadas.

Avançado (Recomendado para Usuários com Experiência Técnica)

Botpress: Plataforma de código aberto que permite criar chatbots altamente personalizáveis. Requer conhecimentos técnicos para configuração e implementação. Possui um plano gratuito com funcionalidades básicas e planos pagos com recursos avançados.

Voiceflow: Focado na criação de assistentes de voz e chatbots complexos, oferece uma interface visual para design de fluxos de conversa. Possui um plano gratuito com recursos limitados e planos pagos para funcionalidades avançadas.

Plataformas de Geração de Modelos de IA Personalizados

Essas plataformas permitem criar modelos de IA que se adaptam especificamente às necessidades do seu projeto.

Por exemplo, com serviços como Azure Machine Learning ou Google AutoML, você pode treinar modelos para prever tendências de mercado ou comportamentos de consumo sem ser um especialista em dados.

Utilizar ferramentas No-Code para desenvolver agentes de IA não apenas economiza tempo, mas também democratiza a tecnologia.

Escolher a ferramenta certa pode ser um divisor de águas no seu projeto ou negócio. Por isso, é importante entender o que cada uma oferece e como pode se alinhar aos seus objetivos.

Essa flexibilidade e acessibilidade são o grande trunfo das ferramentas No-Code na era digital.

Langchain: Uma Ferramenta Base para Agentes de IA

A inteligência artificial (IA) está mudando a maneira como interagimos com a tecnologia.

Hoje, com as plataformas No Code, você não precisa ser um desenvolvedor para criar um agente inteligente. Essas ferramentas simplificam o processo, tornando-o acessível a todos.

Uma das ferramentas mais interessantes é o Lang Chain. Ele permite que qualquer pessoa monte um chatbot sem precisar escrever código.

Isso é ótimo para pequenos negócios ou para quem apenas quer automatizar respostas em redes sociais.

Outras ferramentas como Dante, Zoho Zia, Dify e Synthflow também são populares. Elas oferecem recursos variados que podem ajudar desde o usuário casual até o desenvolvedor mais experiente.

Por exemplo, o Dante é perfeito para quem está começando e quer criar algo simples rapidamente.

Especificamente falando sobre chatbots, ferramentas como Typebot, ManyChat, Botpress, VoiceFlow e Laila se destacam. Elas permitem que você crie bots que não apenas respondem automaticamente, mas também aprendem e se adaptam com o tempo.

Imagine ter um assistente virtual que aprende com as conversas e melhora a cada interação. Isso é possível com essas ferramentas!

É importante entender a diferença entre um chatbot simples e um agente de inteligência artificial mais sofisticado.

A escolha da ferramenta correta pode impactar significativamente na qualidade e na eficiência do seu projeto. Um bom agente inteligente pode economizar tempo, reduzir custos e melhorar a experiência do usuário.

Portanto, se você está pensando em criar seu próprio agente inteligente, considere suas necessidades e escolha a ferramenta adequada. As possibilidades são vastas e as ferramentas estão ao alcance de todos.

Com um pouco de criatividade e as plataformas certas, você pode transformar seu modo de interagir com seus clientes ou seguidores.

Ferramentas Específicas para criar Agentes de IA

Escolher as ferramentas certas para criar agentes de inteligência artificial pode fazer toda a diferença no seu projeto.

Veja algumas das melhores plataformas que podem ajudar tanto iniciantes quanto profissionais experientes a desenvolverem soluções inteligentes de maneira eficaz:

- Dante – Ideal para Iniciantes: Se você está começando e quer experimentar a criação de agentes de IA, o Dante é uma ótima escolha. Ele tem uma interface fácil de usar e já vem com várias configurações prontas, o que simplifica muito o processo de desenvolvimento.

- Zaia – Aprendizado Contínuo: Esta plataforma é conhecida por entender realmente as necessidades dos usuários. Com o Zaia, cada interação ajuda a melhorar as respostas e recomendações, graças ao seu sistema de aprendizado contínuo, tornando-se cada vez mais precisa e útil.

- Chatvolt – Ideal para empresas que buscam atendimento eficiente e adaptado aos seus dados, a Chatvolt utiliza modelos avançados como ChatGPT e outras 39 LLM´s para reduzir custos operacionais e otimizar a experiência do cliente com agentes de IA altamente personalizáveis.

- Dify – Análise Predicativa: Para projetos mais complexos que necessitam de análise preditiva e otimização de processos, o Dify é a escolha certa. Ele oferece ferramentas avançadas de aprendizado de máquina e integração de dados, possibilitando que você crie agentes que podem prever tendências e otimizar operações.

- Synthflow – Foco na Interação: Se o seu projeto precisa de um agente que interaja de forma natural com os usuários, o Synthflow é ideal. Ele combina processamento de linguagem natural com criação de fluxos conversacionais, criando uma experiência de usuário envolvente e dinâmica.

Estas ferramentas foram escolhidas porque oferecem soluções variadas e adaptáveis, dependendo das necessidades de cada projeto.

Escolher a ferramenta correta é crucial para o sucesso do seu agente de IA, pois cada uma tem características distintas que podem beneficiar diferentes tipos de projetos. Por exemplo, se precisar de algo simples e fácil de usar, vá de Dante.

Já para necessidades de aprendizado e adaptação contínua, Zaia ou Chatvolt podem ser a melhor opção. Lembre-se de que um bom projeto começa com a escolha certa das ferramentas!

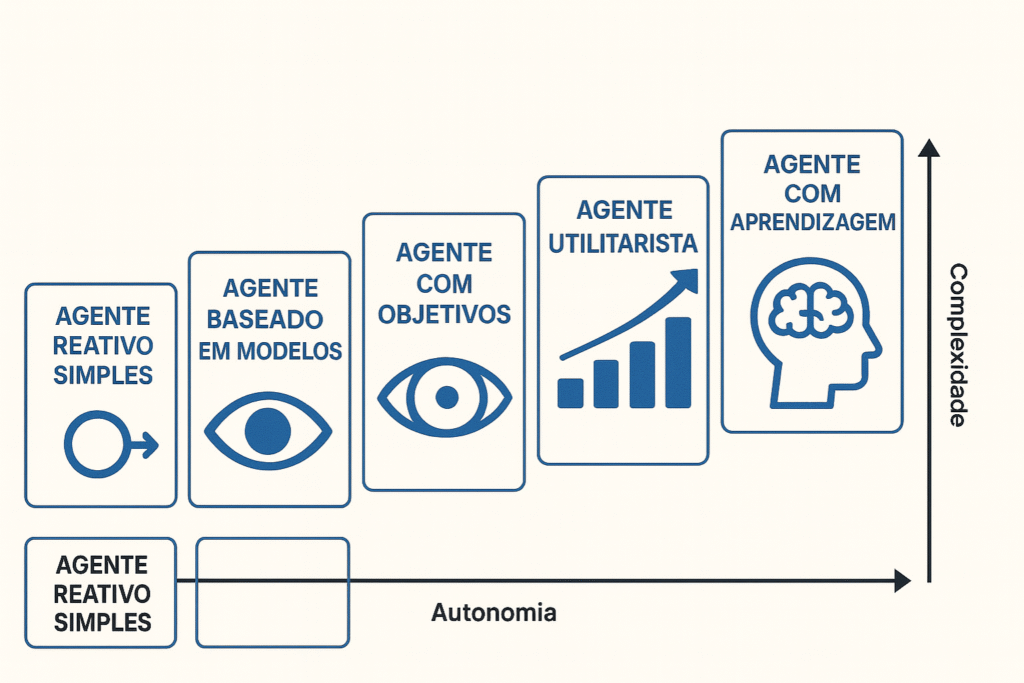

Agentes de IA vs Chatbots: Entenda as Diferenças

Entender a diferença entre chatbots e agentes de IA pode te ajudar a escolher melhor a tecnologia para o seu projeto. Vamos simplificar isso!

Os chatbots são como atendentes automáticos que seguem um script. Eles são ótimos para tarefas simples como responder perguntas frequentes ou marcar um horário.

Imagine que você pergunta a um chatbot sobre o horário de funcionamento de uma loja, e ele responde prontamente com a informação programada.

Já os agentes de IA são mais como assistentes pessoais inteligentes. Eles aprendem com cada interação e melhoram suas respostas com o tempo.

Se você está buscando uma experiência mais personalizada, onde o sistema reconhece seus gostos e preferências, um agente de IA é o mais indicado.

Por exemplo, enquanto um chatbot pode te dar uma resposta padrão sobre uma receita de bolo, um agente de IA pode sugerir ajustes na receita baseado no que aprendeu sobre suas preferências anteriores ou restrições alimentares. Isso mostra como os agentes de IA podem ser mais adaptáveis e pessoais.

Se o seu objetivo é apenas informar ou responder perguntas simples, um chatbot pode ser suficiente. Mas se você busca oferecer uma experiência única e adaptada para cada usuário, um agente de IA pode ser a melhor escolha.

Avalie suas necessidades e veja qual tecnologia se encaixa melhor para oferecer o melhor serviço aos seus usuários.

Lembre-se, a escolha entre um chatbot e um agente de IA pode definir o nível de satisfação do seu usuário com a interação. Opte pela tecnologia que melhor se adapta ao seu objetivo e ofereça uma experiência marcante e eficiente.

Arquitetura de Software: Construindo Aplicações Inteligentes

Quando falamos sobre a construção de aplicações de inteligência artificial (IA), a arquitetura de software é o alicerce que sustenta tudo. É como se fosse o esqueleto de um prédio: se não for bem projetado, o prédio não fica firme.

Para que um agente de IA funcione bem, ele precisa de uma estrutura que o suporte de maneira eficiente, garantindo não apenas seu funcionamento agora, mas também sua evolução futura.

Existem alguns pontos chave que você precisa considerar ao projetar essa arquitetura:

- Organização dos Dados: Imagine que os dados são o combustível do seu agente de IA. Se esse combustível não estiver bem organizado, o agente não vai conseguir performar bem. Uma base de dados bem estruturada permite que o agente encontre rapidamente o que precisa, tornando todo o processo mais ágil e eficaz.

- Processos Claros: É essencial ter uma visão clara de como cada processo do agente vai funcionar, desde a coleta de dados até a interação com o usuário. Isso ajuda a evitar erros e garante que o agente sempre saiba o que fazer em cada situação.

- Integração com Outros Serviços: Hoje em dia, um agente de IA raramente trabalha sozinho. Ele precisa se comunicar com outras aplicações e serviços. Uma arquitetura flexível facilita essa integração, permitindo que seu agente se adapte e use recursos de outros sistemas para melhorar seu desempenho.

- Escolha de Algoritmos: Os algoritmos são o coração do seu agente de IA. Escolher os mais adequados e implementá-los corretamente é fundamental para que seu agente possa aprender e se adaptar com o tempo, melhorando sua precisão e eficiência.

Além desses elementos, é importante pensar na escalabilidade e adaptabilidade da sua arquitetura. Isso significa projetar pensando não só nas necessidades atuais, mas também nas futuras.

Um agente de IA que pode crescer e se adaptar com o tempo é muito mais valioso, pois pode continuar sendo útil à medida que novas tecnologias e exigências surgem.

Portanto, uma arquitetura bem planejada não é apenas um detalhe técnico; é o que permite que sua aplicação de IA realmente entregue resultados e se mantenha relevante no mercado.

Investir tempo e recursos nessa fundação vai te poupar muita dor de cabeça e garantir que seu projeto de IA seja um sucesso.

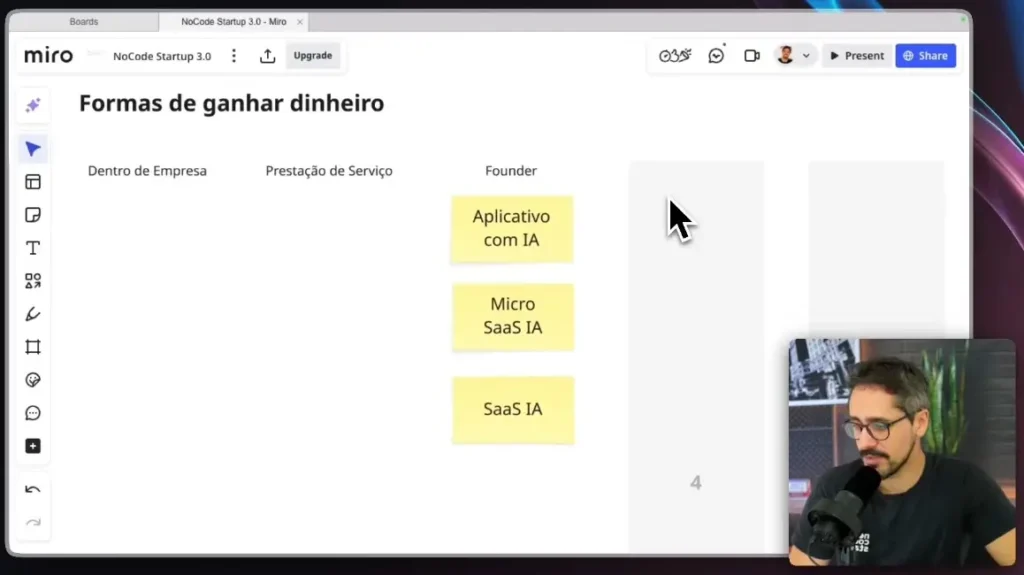

Revolucionando a Criação de Softwares com IA

Neste artigo, exploramos como a inteligência artificial está mudando a forma como criamos softwares, especialmente com a ajuda de ferramentas No-Code.

Você viu a diferença entre agentes de IA e chatbots, descobriu ferramentas para desenvolver agentes sem precisar programar, e entendeu a importância da arquitetura de software.

Agora, com esse conhecimento, você pode dar vida às suas ideias, criando projetos mais inteligentes e eficientes.

Pronto para usar o que aprendeu?

As ferramentas No-Code não só simplificam a criação de agentes de IA, como também abrem portas para inovações sem fim.

Você não precisa ser um expert em programação para trazer suas ideias para o mundo digital.

Agora que você tem o conhecimento e as ferramentas, que tal começar a criar? A tecnologia No-Code está aqui para facilitar seu trabalho e expandir suas possibilidades.

Com a NoCode StartUp, você tem tudo para transformar suas ideias em realidade. Entre em nosso curso NocodeIA e aprenda a utilizar o melhor do mundo Nocode com Inteligência Artificial.

Leitura complementar:

FAQ – Perguntas e Respostas Frequentes

Como posso criar agentes de IA gratuitamente?

Use uma stack no‑/low‑code com planos grátis ou open‑source: Dify CE ou Flowise/LangFlow para o agente, n8n self‑host para integrações, Ollama com modelos locais (Llama/Mistral) e ChromaDB/FAISS para RAG; defina o caso de uso, indexe seus arquivos, conecte ferramentas e publique via web (WhatsApp geralmente exige provedor pago).

Como criar a própria IA?

Para a maioria dos projetos, crie seu agente usando modelos prontos com Dify/Voiceflow/Flowise + n8n/Make e RAG sobre seus dados; se quiser seu modelo, faça fine‑tuning de um base open‑source (ex.: Llama) com LoRA/QLoRA e sirva via API, mas em negócios, RAG costuma ser mais rápido e barato que treinar do zero.

Quanto custa um agente IA?

Vai do uso e dos canais: protótipo local pode sair R$0; MVP típico fica em R$200–R$900/mês (API de modelo + orquestração + hospedagem); escala média costuma variar de R$1,5k–R$6k+/mês; os maiores drivers são modelo (tokens/GPU), canal (WhatsApp/voz), base vetorial e monitoramento.