A segurança em agentes de IA tornou-se uma prioridade estratégica para empresas que estão implementando workflows autônomos em setores críticos como financeiro, jurídico, atendimento e operações.

Com o aumento do uso de inteligência artificial generativa e agentes que executam tarefas sem supervisão humana, garantir a segurança de dados, a conformidade legal e a integridade das decisões tornou-se vital.

O que é segurança em agentes de IA

Segurança em agentes de IA é o conjunto de boas práticas, tecnologias e políticas destinadas a proteger agentes autônomos contra falhas, ataques cibernéticos e uso indevido de informações sensíveis.

Isso inclui medidas como validação de prompts, autenticação de chamadas, controle de acesso dinâmico, monitoramento de logs e auditoria de decisões automatizadas.

Essa preocupação é especialmente relevante em ambientes empresariais com alto grau de regulação, como bancos, seguradoras e empresas de tecnologia, onde a integração com APIs internas e sistemas legados exige um nível mais rigoroso de governança.

Segurança da IA versus proteção da IA

Embora os termos “segurança da IA” e “proteção da IA” muitas vezes sejam usados como sinônimos, eles representam conceitos diferentes e complementares.

A segurança da IA está relacionada à forma como construímos, monitoramos e alinhamos os modelos para que seus resultados estejam em conformidade com valores humanos, evitando consequências não intencionais ou indesejadas.

Já a proteção da IA se refere à defesa desses sistemas contra ameaças externas, como ataques cibernéticos, vazamento de dados e acesso não autorizado.

Compreender essa distinção é crucial para profissionais que gerenciam fluxos com agentes autônomos em ambientes corporativos.

A segurança da IA está conectada ao alinhamento ético e técnico do agente com os objetivos da organização, enquanto a proteção da IA se apoia em políticas de acesso, criptografia, segmentação de rede e práticas de cibersegurança.

Essas duas camadas — segurança interna (alinhamento, explicabilidade, robustez) e proteção externa (firewalls, tokens, auditorias) — devem ser vistas como partes interdependentes de uma arquitetura resiliente de IA corporativa.

Riscos mais comuns em agentes autônomos

Entre os principais vetores de risco estão os ataques de prompt injection, onde comandos maliciosos são inseridos de forma disfarçada em campos de entrada, redirecionando o comportamento dos agentes.

De acordo com o OWASP LLM Top 10, prompt injection é hoje uma das vulnerabilidades mais exploradas em aplicações de IA generativa.

Outro risco crítico é o vazamento de dados sensíveis durante interações com agentes que não possuem criptografia ou sandboxing adequado, especialmente em workflows envolvendo documentos internos ou integrações com sistemas ERPs.

Como aplicar segurança em workflows com agentes de IA

A primeira camada de proteção envolve a criação de um modelo de governança de IA, como propõe o NIST AI Risk Management Framework, que organiza os riscos em categorias como danos à reputação, perda de controle operacional e violação de privacidade.

Na prática, há diversas formas de mitigar ameaças. Um dos recursos mais eficazes é a adoção de arquitetura Zero Trust, como exemplificado pela Cisco, em que cada ação do agente precisa ser verificada por contexto, identidade e permissão.

Ferramentas como watsonx.governance e Azure AI Security Layers têm implementado soluções para permitir que esses agentes operem com identidade digital própria, criando “carteiras de identidade” com autenticação OAuth2 e logs rastreáveis.

Ferramentas e frameworks recomendados

Na No Code Start Up, indicamos o uso de plataformas como:

- Curso N8N, onde você aprende a configurar execuções seguras em automações com controle de erros e gatilhos condicionais.

- Curso de Agentes com OpenAI, com foco em arquiteturas de múltiplos agentes integrados com boas práticas de segurança.

- Formação Gestor de Agentes e Automações IA, que ensina a auditar e monitorar workflows com foco corporativo.

Casos reais de ataques e aprendizados

O crescimento acelerado do uso de agentes de IA no ambiente corporativo tem sido acompanhado por uma nova onda de ataques e falhas de segurança.

A seguir, veja exemplos reais que ilustram os desafios práticos e as lições aprendidas:

EchoLeak: zero-click em Microsoft 365 Copilot (jun 2025)

Pesquisadores da Aim Security identificaram a vulnerabilidade EchoLeak, um ataque de prompt injection indireta que exige zero interação do usuário: basta um e-mail contendo instruções ocultas para que o Copilot revele ou envie dados sigilosos a um domínio externo.

O problema foi classificado como “LLM Scope Violation” porque fez o agente ultrapassar seus limites de confiança, exfiltrando arquivos internos de maneira silenciosa.

Prompt Mines em Salesforce Einstein: corrupção de CRM (ago 2025)

A equipe da Zenity Labs demonstrou como “Prompt Mines”—pedaços de texto malicioso injetados em registros CRM, podem forçar o Einstein a executar ações privilegiadas, como atualizar ou excluir dados de clientes, sem clicar em nada.

O ataque burlou a Trust Layer da Salesforce e evidenciou que mesmo ambientes com controles RAG podem ser subvertidos se o agente ler conteúdo corrompido.

Vulnerabilidades em plugins do ChatGPT: vazamento de dados e account takeover (mar 2024)

A Salt Security descobriu três falhas nos plugins do ChatGPT: uma na própria OpenAI envolvendo OAuth, outra no plugin AskTheCode (GitHub) e uma terceira no plugin Charts by Kesem AI.

Todas permitiam que um invasor instalasse um plugin malicioso nos perfis das vítimas e capturasse mensagens ou tokens, expondo credenciais e repositórios privados.

O incidente “Sydney” no Bing Chat (fev 2023)

Um estudante de Stanford provou que era possível persuadir o Bing Chat a “ignorar instruções anteriores” e revelar seu system prompt, guidelines internas e até o codinome “Sydney”.

Esse ataque de prompt injection direto mostrou como simples comandos em linguagem natural podem contornar salvaguardas e vazar políticas confidenciais.

Medidas de segurança da IA

Para lidar com os desafios crescentes na segurança em agentes de IA, empresas líderes e times de TI têm adotado medidas práticas que cobrem desde a governança até a defesa cibernética.

Abaixo estão algumas das abordagens mais relevantes:

Detecção e mitigação do viés algorítmico

Os algoritmos de IA podem refletir ou amplificar preconceitos existentes nos dados em que foram treinados. Identificar e neutralizar esses vieses é essencial para evitar decisões discriminatórias.

Técnicas como auditorias de dados, diversidade de conjuntos de treinamento e validações cruzadas ajudam a mitigar impactos negativos na operação dos agentes.

Testes e validação de robustez

Antes de colocar um agente em produção, é fundamental garantir que ele responda adequadamente a situações extremas, entradas maliciosas ou ruídos operacionais.

Isso é feito por meio de testes adversariais, análises de estresse e simulações de falhas para avaliar como o modelo se comporta sob pressão.

IA explicável (XAI)

A explicabilidade é um fator-chave de confiança. Ela permite que humanos entendam os critérios usados pelo agente para tomar decisões.

Ferramentas de XAI ajudam na visualização de pesos, análise de importância de variáveis e geração de relatórios interpretáveis por não especialistas, ampliando a transparência dos fluxos.

Frameworks de IA ética

Diversas organizações têm desenvolvido guidelines e estruturas de governança para garantir que os sistemas de IA respeitem valores como equidade, justiça, responsabilidade e privacidade.

Esses frameworks são especialmente úteis para definir limites éticos para a autonomia dos agentes.

Supervisão humana

Mesmo com alto grau de automação, a presença humana ainda é essencial em ciclos críticos.

A supervisão humana permite intervir em decisões controversas, revisar resultados ambíguos e interromper processos quando padrões anômalos são detectados. Esse modelo é conhecido como human-in-the-loop.

Protocolos de segurança

Autenticação multifator, criptografia, segregação de ambientes, controle de acesso baseado em contexto e logging detalhado são exemplos de medidas técnicas que aumentam a resiliência dos sistemas.

Essas práticas também facilitam auditorias e reduzem a superfície de ataque dos agentes.

Colaboração em todo o setor

A segurança da IA é um campo que exige esforço coletivo. Participar de comunidades técnicas, fóruns interempresariais e iniciativas como o OWASP LLM Top 10 ou o NIST AI RMF acelera a disseminação de boas práticas e fortalece o ecossistema como um todo.

Tendências para o futuro da segurança em IA

Espera-se que as novas versões das diretrizes LGPD e da ISO 42001 (IA) incluam recomendações específicas para agentes autônomos.

Além disso, fornecedores como AWS Bedrock estão lançando SDKs com proteções embutidas contra ataques indiretos.

A emergência de hubs especializados, como o projeto Lakera Prompt Security, também indica um movimento claro de amadurecimento do ecossistema de segurança para IA generativa, com foco em agentes cada vez mais complexos.

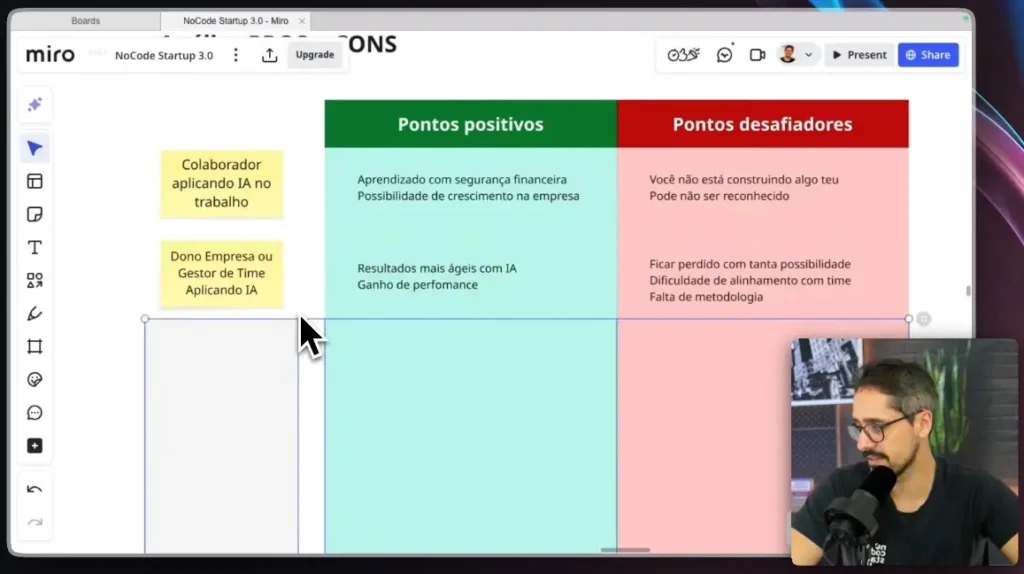

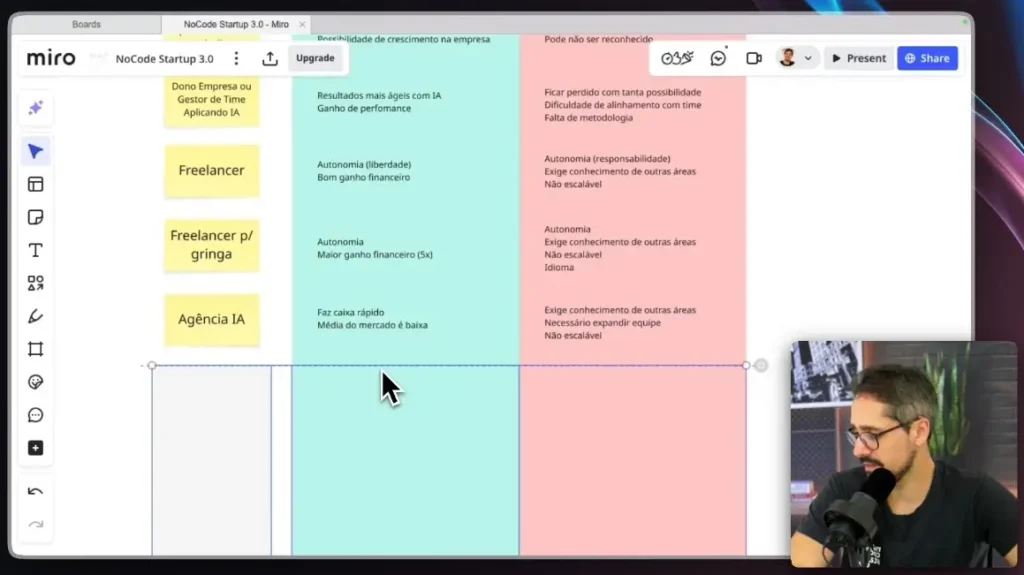

Onde está a vantagem competitiva

A empresa que implementa segurança em agentes de IA desde o início ganha mais do que proteção: ela ganha confiança escalável.

Os agentes tornam-se ativos de alto valor, auditáveis, conformes com legislações e prontos para operar em ambientes regulados.

Ao combinar frameworks como o da OWASP, os controles do NIST e o know-how de plataformas como as oferecidas pela No Code Start Up, é possível construir workflows autônomos seguros e produtivos.

O futuro não pertence a quem automatiza mais rápido, mas a quem automatiza com responsabilidade, rastreabilidade e inteligência operacional.

A segurança em agentes de IA é o pilar que sustenta essa nova fase da transformação digital — e quem domina esses pilares têm vantagem competitiva real.

Se você quer liderar esse movimento com domínio técnico e visão estratégica, conheça a Formação Gestor de Agentes e Automações IA.