A introdução massiva da Inteligência Artificial sinaliza o ponto de inflexão mais crítico da década, transformando a física do conflito digital.

Não estamos apenas diante de novas ferramentas, mas vivendo a consolidação da cibersegurança na era da IA generativa, onde a velocidade da máquina passa a ditar a sobrevivência organizacional.

Conforme aponta o relatório global da Research and Markets, a IA será o pilar central das estratégias de defesa até 2031, marcando a transição definitiva da curiosidade para a integração sistêmica.

Para profissionais de tecnologia e desenvolvedores No-Code, dominar esse cenário é a única forma de proteger ativos e reputação contra ameaças que evoluem em tempo real.

A Nova Física do Conflito Digital: Entendendo a Cibersegurança na Era da IA Generativa

A grande revolução trazida pela Inteligência Artificial Generativa no campo da segurança da informação não reside apenas na sofisticação dos ataques, mas na drástica redução das barreiras de entrada para o cibercrime.

Antigamente, realizar um ataque complexo exigia anos de experiência em programação e criptografia.

Hoje, a cibersegurança na era da IA generativa enfrenta adversários que utilizam modelos de linguagem (LLMs) modificados para escrever malware, criar e-mails de phishing perfeitos e automatizar invasões.

A Democratização do Cibercrime e a Redução da Barreira de Entrada

O surgimento de ferramentas conhecidas no submundo digital como WormGPT e FraudGPT ilustra perfeitamente este novo cenário.

Estas são versões “sem amarras” de modelos de linguagem populares, treinadas especificamente com dados de malware e técnicas de exploração de vulnerabilidades.

Isso permite que agentes mal-intencionados com pouco ou nenhum conhecimento técnico executem ataques que, anteriormente, seriam exclusividade de hackers de elite.

Essa “commoditização” do ataque significa que pequenas e médias empresas agora estão na mira de campanhas automatizadas.

Setores críticos, como o bancário, já sentem essa pressão, vivendo o que especialistas chamam de uma batalha assimétrica entre a IA dos bancos e a IA dos cibercriminosos, onde a defesa precisa estar sempre um passo à frente.

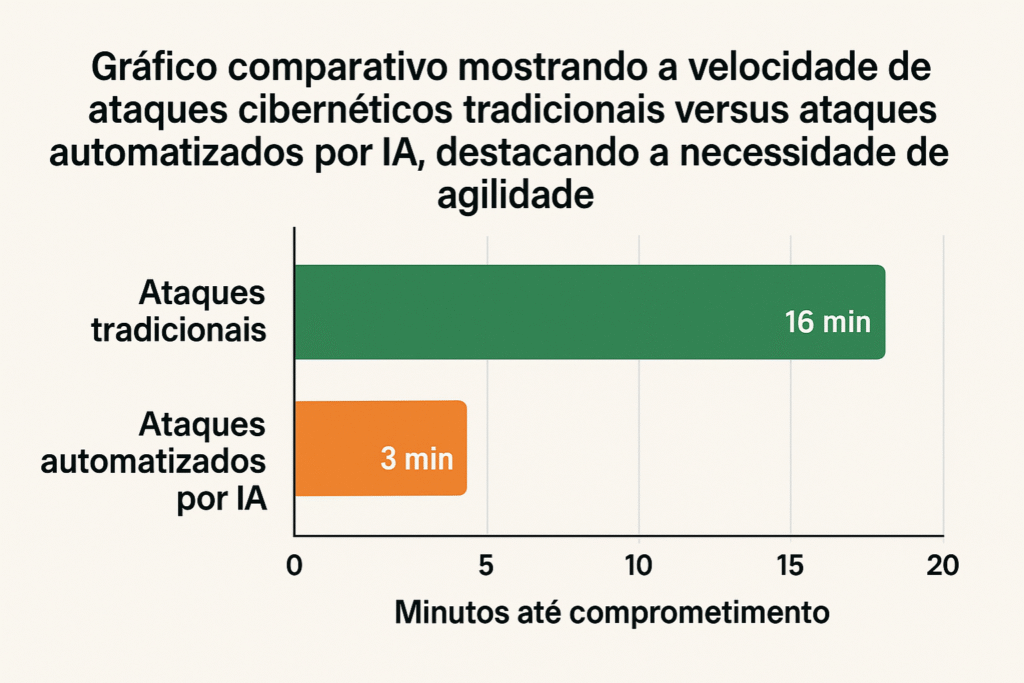

A Velocidade da Máquina vs. A Velocidade Humana

Outro fator crucial é a assimetria temporal. Enquanto uma equipe de segurança humana pode levar minutos ou horas para triar um alerta, um sistema de ataque baseado em IA opera em milissegundos.

A batalha agora é travada em velocidade de máquina.

Por isso, a defesa moderna não pode depender exclusivamente de reações manuais. É necessário integrar soluções que utilizem a própria IA para combater a IA, criando sistemas de imunidade digital que aprendem autonomamente.

Entender o que é infraestrutura de IA e como ela sustenta essas defesas torna-se um conhecimento base para qualquer gestor de tecnologia que deseja manter sua operação resiliente.

As 4 Principais Ameaças Amplificadas pela IA Generativa

Para proteger sua organização, é vital dissecar as táticas que estão sendo potencializadas pela tecnologia.

A cibersegurança na era da IA generativa não lida apenas com novos códigos, mas com a manipulação psicológica em escala.

Engenharia Social em Escala Industrial (Phishing 2.0)

O phishing tradicional era identificável por erros gramaticais. A IA generativa eliminou essas falhas.

Hoje, atacantes podem gerar e-mails de spear-phishing hiper-personalizados, imitando o tom de voz e o vocabulário da vítima.

Essa capacidade de personalização em massa torna a engenharia social extremamente difícil de ser detectada por filtros tradicionais.

Deepfakes e a Crise de Identidade Digital

Talvez a face mais visível da cibersegurança na era da IA generativa seja o uso de deepfakes.

O setor financeiro e jurídico tem estado em alerta máximo. Recentemente, o Conselho Nacional de Justiça (CNJ) precisou intervir, estabelecendo normas rígidas para o uso da tecnologia visando mitigar riscos de fraudes processuais e de identidade.

A verificação de identidade agora precisa evoluir para provas de vida criptográficas e autenticação multifator rigorosa (MFA), pois a confiança nos sentidos humanos (“ver para crer”) foi quebrada.

Shadow AI e o Vazamento Silencioso de Dados Corporativos

O conceito de “Shadow AI” ocorre quando funcionários inserem dados confidenciais em ferramentas de IA públicas.

Essas informações podem passar a fazer parte do treinamento de modelos públicos, criando vazamentos de propriedade intelectual.

Implementar soluções de Agentes de IA e Automação dentro de um ambiente controlado e sancionado pela empresa é a resposta mais eficaz para mitigar esse risco, oferecendo aos colaboradores as ferramentas que eles desejam, mas com a governança necessária.

Envenenamento de Dados e Prompt Injection

Além de proteger os dados de saída, devemos nos preocupar com a integridade dos dados de entrada.

Ataques de “Data Poisoning” visam corromper os modelos de IA durante seu treinamento. Já o “Prompt Injection” manipula a saída de um modelo através de comandos maliciosos.

Estratégias de Defesa: Como Construir uma Fortaleza Digital

A postura defensiva deve mudar de “bloqueio de perímetro” para “resiliência contínua”.

A cibersegurança na era da IA generativa exige uma abordagem que combine tecnologia, processos e conformidade regulatória.

Adoção Rigorosa do Modelo Zero Trust

O novo mantra é “nunca confie, verifique sempre”. A arquitetura Zero Trust assume que a violação é inevitável. Nenhuma identidade deve ter acesso implícito a recursos da rede.

Na prática, isso significa segmentação de rede e verificação contínua, bloqueando comportamentos anômalos mesmo após a autenticação inicial.

Governança de IA e Conformidade (ISO 42001 e Normas CNJ)

A implementação de IA não pode ser desordenada. Além de frameworks internacionais como a ISO/IEC 42001 (Sistema de Gestão de IA), o cenário nacional também avança na regulação.

A Resolução CNJ nº 615/2025, por exemplo, define diretrizes claras para governança, auditabilidade e segurança no uso de IA generativa pelo judiciário, servindo de modelo para outros setores regulados.

Empresas maduras estão estabelecendo comitês de ética para garantir que o uso da IA esteja em conformidade com essas novas exigências legais e técnicas.

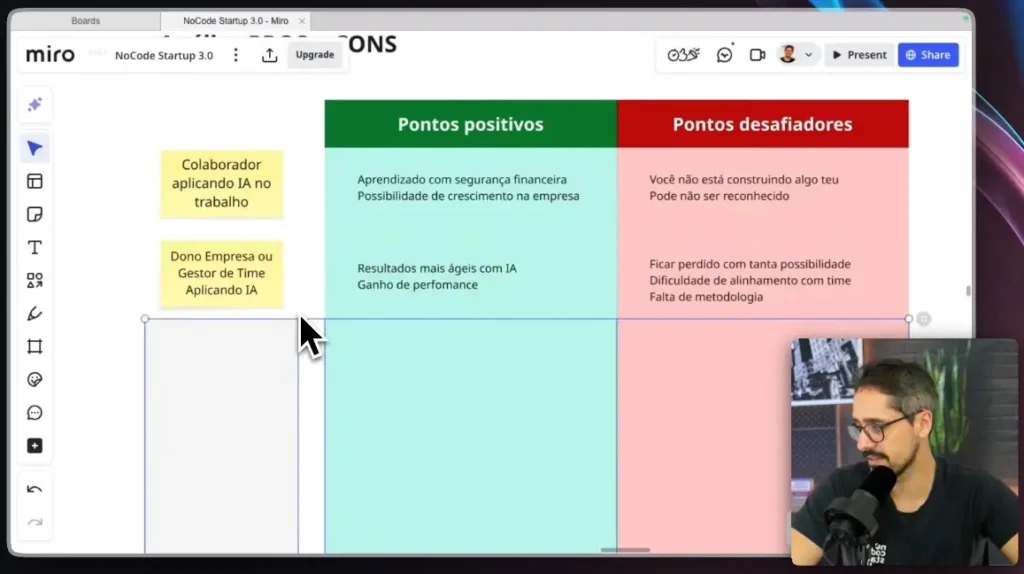

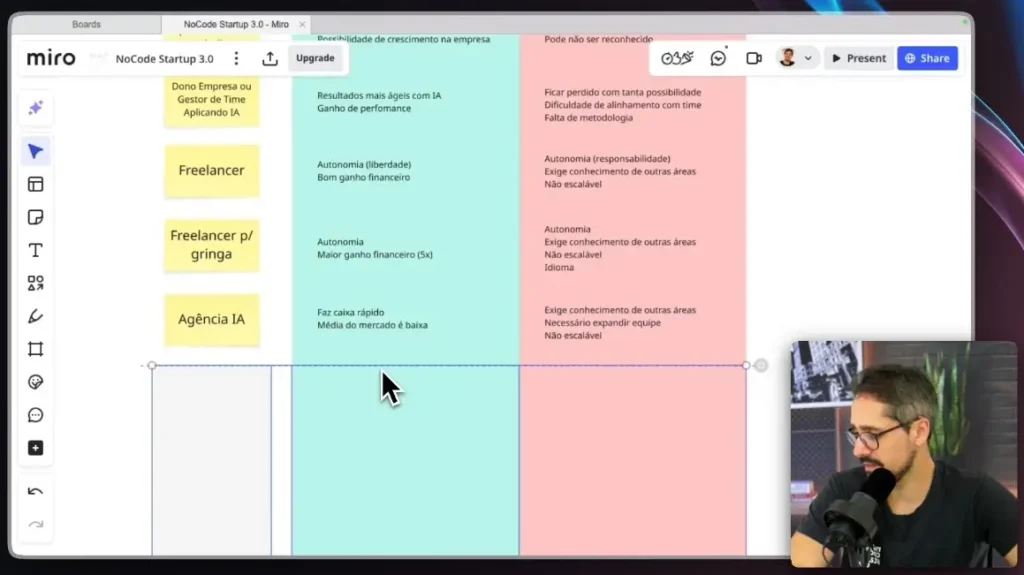

O Profissional No-Code como Agente de Segurança

Na cibersegurança na era da IA generativa, o desenvolvedor cidadão tem um papel protagonista.

Ao criar automações e aplicativos que processam dados de negócios, você está construindo infraestrutura crítica.

Segurança por Design no Desenvolvimento Visual

Plataformas modernas possuem recursos robustos, mas precisam ser configurados corretamente.

Isso inclui definir regras de privacidade no banco de dados (Row Level Security) e gerenciar chaves de API com segurança.

O desconhecimento dessas práticas é a principal vulnerabilidade em projetos Low-Code.

A Importância da Capacitação Contínua em AI Coding

Não basta apenas saber arrastar componentes. É fundamental entender a lógica de integração de APIs de inteligência artificial de forma segura.

A Formação AI Coding da No Code Start Up prepara profissionais para esse desafio, ensinando a arquitetar soluções escaláveis que respeitam as melhores práticas de segurança e privacidade desde o primeiro dia.

Perguntas Frequentes sobre Cibersegurança na Era da IA Generativa

A IA generativa vai substituir os profissionais de cibersegurança?

Não. A IA funcionará como um multiplicador de força. Relatórios como o da ResearchAndMarkets indicam que a demanda por profissionais qualificados para gerenciar essas ferramentas e estratégias complexas continuará crescendo.

Como proteger minha empresa contra deepfakes em reuniões online?

Estabeleça protocolos de verificação “out-of-band”. Se houver solicitações financeiras urgentes por vídeo, confirme por outro canal. A conscientização sobre as táticas usadas em fraudes bancárias com IA é a primeira linha de defesa.

Quais ferramentas de IA são seguras para uso corporativo?

Prefira versões “Enterprise” que garantem contratualmente a privacidade dos dados, evitando que suas informações treinem modelos públicos.

O que é “Shadow AI”?

É o uso não monitorado de IA por funcionários. Isso cria riscos de vazamento de dados e violação de normas como a Resolução CNJ nº 615, que exige controle estrito sobre as ferramentas tecnológicas utilizadas.

O No-Code é seguro?

Sim, se bem implementado. A segurança depende da configuração correta das permissões e da autenticação, temas centrais em qualquer formação profissional de desenvolvimento.

O Caminho à Frente: Vigilância e Adaptação

A cibersegurança na era da IA generativa não é um destino final, mas uma jornada contínua. As ferramentas que inovam são as mesmas que exigem cautela.

A resposta está na educação técnica aprofundada, na governança robusta baseada em normas internacionais e na escolha de parceiros que priorizem a segurança.

Para as empresas, investir em defesa baseada em IA é mandatório. Para os profissionais, elevar a barra do conhecimento é a única forma de se manter relevante e seguro.

O futuro pertence a quem constrói com inteligência e protege com rigor.

Domine a Criação de Softwares Seguros com IA

Não deixe para aprender quando for tarde demais. Se você quer estar na vanguarda do desenvolvimento e garantir que suas aplicações sejam robustas e seguras, conheça a Formação AI Coding da No Code Start Up.

Aprenda a criar softwares avançados com Inteligência Artificial e Low-Code, aplicando as melhores práticas de segurança e governança desde a primeira linha de lógica.