Até recentemente, a OpenAI dominava o mundo da inteligência artificial (IA) e dos chatbots, com seu modelo de linguagem grande (LLM) GPT-4 alimentando o ChatGPT e o Copilot da Microsoft. A liderança inicial da OpenAI manteve outros tentando se atualizar.

No entanto, a OpenAI enfrenta agora um novo desafiante: o Google Gemini. Lançado em fevereiro de 2024, após seu anúncio no final de 2023, o Gemini rapidamente causou ondas significativas no cenário da IA.

Mas será suficiente para superar o GPT-4? Quais capacidades o Gemini tem agora e o que podemos esperar no futuro? E como você pode começar a usar essa ferramenta?

Exploramos Gemini em profundidade para responder a essas perguntas e muito mais. Se você está curioso sobre a IA mais recente do Google, este é o lugar para estar.

O que é o Google Gemini?

Gemini é o mais recente modelo de linguagem grande (LLM) do Google. Um LLM é um sistema que sustenta várias ferramentas de IA que você provavelmente encontrou online.

Por exemplo, o GPT-4 alimenta o ChatGPT Plus, o chatbot avançado pago da OpenAI.

Sendo mais do que apenas um modelo de IA; também assumiu a nova identidade do chatbot Bard.

Portanto, Bard foi totalmente substituído por Gemini, unificando o modelo subjacente e o chatbot sob um nome.

O Google também lançou um aplicativo gratuito para Android, que pode substituir o Google Assistant no seu telefone. No iOS, essa ferramenta aparece no Google app.

Além disso, o Google rebatizou seu serviço Duet AI para empresas como Gemini for Workspace, oferecendo um conjunto de recursos relacionados à produtividade.

Há também um serviço de assinatura, Gemini Advanced, alimentado por um LLM mais robusto chamado Gemini Ultra.

Em resumo, todas as propriedades de IA do Google estão agora unificadas sob a égide do Gemini, simplificando o acesso, seja para consumidores ou empresas, via web, assistente de smartphone ou aplicativo.

O que a IA Gemini faz?

Resumindo: muito. Ela abrange uma ampla gama de recursos de IA fornecidos por meio de várias plataformas.

O Google descreve o Gemini como uma ferramenta multimodal, capaz de lidar com múltiplas formas de entrada e saída, incluindo texto, código, áudio, imagens e vídeos. Essa versatilidade permite executar uma ampla gama de tarefas.

O Google implementou dois LLMs separados: Gemini 1.0 Pro, que alimenta a versão gratuita, e 1.0 Ultra, que impulsiona o serviço de assinatura do Advanced.

Embora a versão Pro gratuita seja mais simples e menos criativa, o Ultra pago oferece respostas mais profundas e precisas e gerenciamento de tarefas complexas, como codificação.

Gemini Pro pode responder perguntas simples, resumir textos e criar imagens. Ele se integra a outros serviços do Google, como Gmail, Google Maps e YouTube.

Por exemplo, pedir recomendações de passeios turísticos produzirá resultados no Google Maps.

O aplicativo no Android pode substituir o Google Assistente, tratando de consultas e integrando-se a outros serviços do Google. No entanto, Gemini tem suas limitações.

Ele pode ser mais lento que o Google Assistente e ainda apresenta bugs, como interação inconsistente com fotos.

Apesar desses problemas, o Google está melhorando rapidamente a funcionalidade em dispositivos móveis.

Gemini Ultra, o modelo de assinatura, oferece recursos avançados, incluindo o tratamento de consultas em várias etapas e o fornecimento de respostas mais precisas e organizadas.

Em breve, ele será integrado ao Google Docs, Gmail e outros aplicativos de produtividade para assinantes avançados.

Olhando para o futuro, o Google já está trabalhando em seu modelo de próxima geração, Gemini 1.5, que aprimorará ambos os LLMs.

Os primeiros testes da versão Pro mostram melhorias dramáticas, como a extração de momentos cômicos de uma transcrição de 400 páginas da Apollo 11 em apenas 30 segundos.

Quando foi lançado?

O Google Gemini foi lançado em 8 de fevereiro de 2024, substituindo Bard. Ele estava imediatamente disponível em versões gratuitas e pagas, com o aplicativo Android sendo lançado nos EUA.

O aplicativo para iOS agora está disponível no Google app, embora de forma mais limitada em comparação ao Android.

O Google Gemini é gratuito?

A versão padrão do Google é gratuita, mas é mais limitada que a versão paga, Gemini Advanced.

A assinatura custa R$96,99 por mês, com uma avaliação gratuita de dois meses disponível. Esta assinatura faz parte do plano Google One AI Premium.

Sendo que a mesma também inclui 2 TB de armazenamento em nuvem e outros benefícios.

Assim, dado que o Google One com armazenamento de 2 TB já custa R$ 38,99 por mês, a assinatura Advanced oferece um valor substancial para quem precisa de armazenamento em nuvem.

Como faço para usar?

O uso do Google Gemini depende da versão e do produto ao qual está integrado. Você pode usar a IA diretamente no site oficial ou por meio do aplicativo.

O app está disponível no seu telefone Android, onde pode substituir o Google Assistente. No iOS, funciona no Google app. Além disso, você pode assinar o Gemini Advanced para uma experiência de IA mais poderosa.

Gemini vs. GPT-4: Qual é a diferença?

Como o Gemini se compara ao GPT-4 na competição de grandes modelos de linguagem? Quando o Google revelou o Gemini pela primeira vez, afirmou que ele ultrapassou o GPT-4 em vários benchmarks.

O Google informou que o Gemini superou o GPT-4 em sete dos oito benchmarks baseados em texto e em todos os dez benchmarks multimodais.

No entanto, desde que o GPT-4 foi lançado em março de 2023, o Gemini está essencialmente alcançando um rival de quase um ano.

Concluindo, embora essa tecnologia tenha rapidamente se tornado um participante significativo no cenário da IA, a competição com o GPT-4 e os modelos futuros permanece acirrada.

Em suma, o Google Gemini representa um avanço significativo no cenário da IA, oferecendo um conjunto versátil e poderoso de ferramentas que rivaliza com o domínio estabelecido do GPT-4 da OpenAI.

Portanto, com a sua integração abrangente entre aplicações de consumo e de negócios, essa tecnologia posicionou-se como um concorrente formidável.

Embora ainda enfrente desafios e limitações, especialmente na sua versão gratuita, as rápidas melhorias e a promessa de atualizações futuras como a versão 1.5 indicam um futuro brilhante.

Assim, à medida que o campo da IA continua a evoluir, a competição entre o Google Gemini e o GPT-4 da OpenAI impulsionará a inovação, beneficiando, em última análise, os utilizadores com soluções de IA mais sofisticadas e capazes.

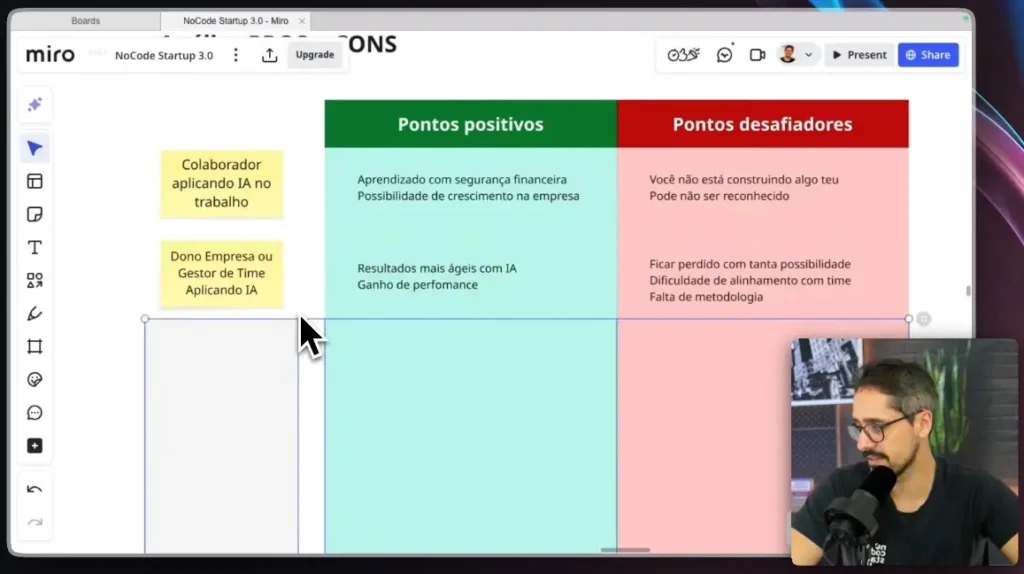

Quer saber mais sobre como criar um software ou atomações de inteligência artificial? Não deixe de conferir nossa formação NoCodeIA.

Descubra como tantas pessoas estão ganhando muito dinheiro com essa oportunidade de negócio, independentemente da sua área de atuação!

Leitura complementar: